Zur Version ohne Bilder

freiesMagazin Dezember 2011 (ISSN 1867-7991)

Topthemen dieser Ausgabe

Python-Frameworks für HTML-Formulare

Python ist heutzutage eine feste Größe unter den Programmiersprachen – auch, wenn es um das Schreiben von Webanwendungen geht. Wer eine solche programmiert, möchte früher oder später auch Daten vom Nutzer eingeben lassen. Hier kommen dann HTML-Formulare ins Spiel. Im Rahmen des Artikels werden fünf verschiedenen Frameworks für Python vorgestellt, welche den Umgang mit diesen Formularen erleichtern sollen. (weiterlesen)

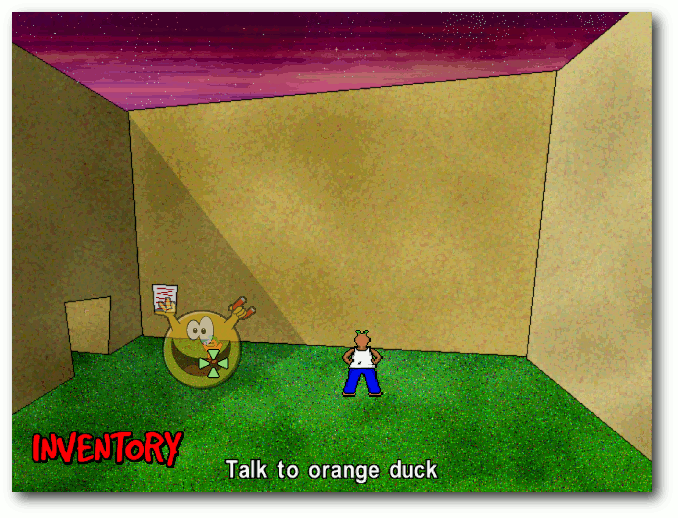

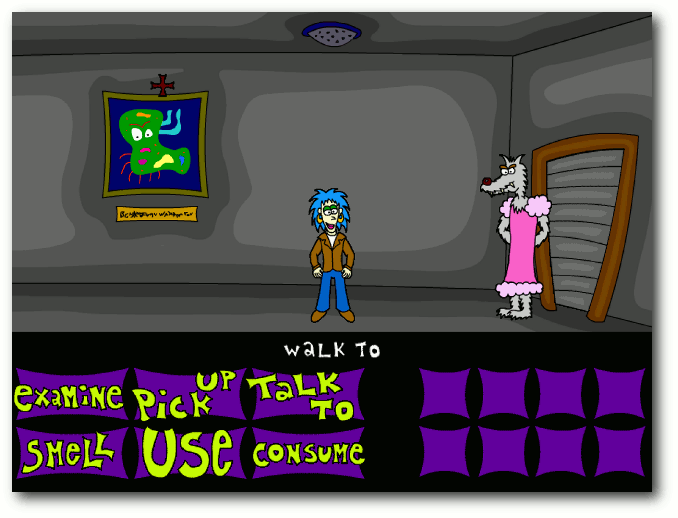

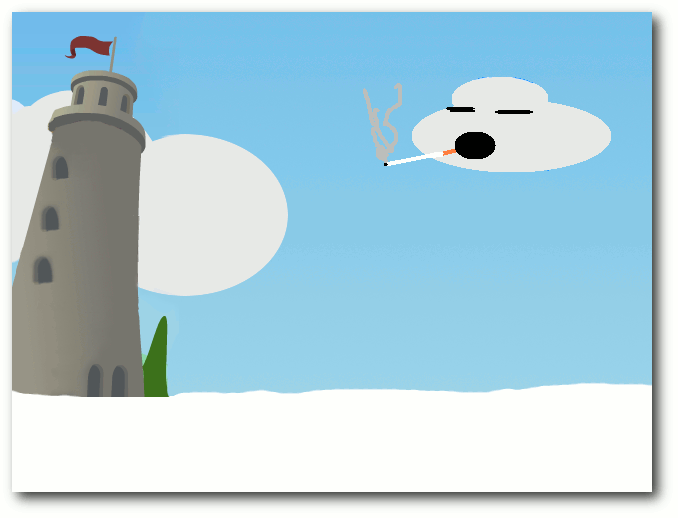

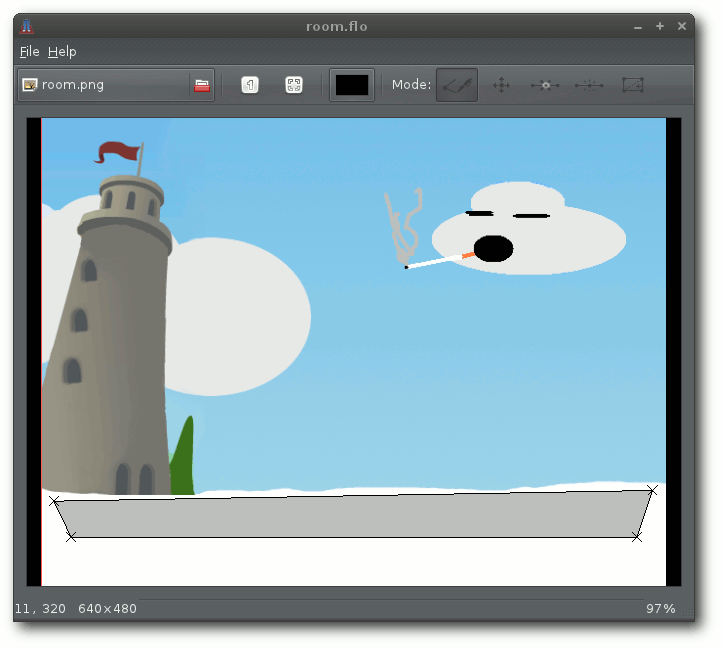

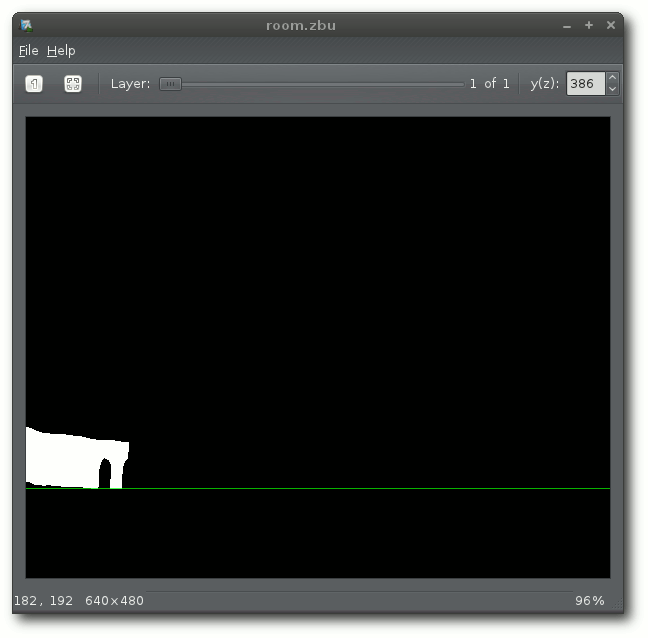

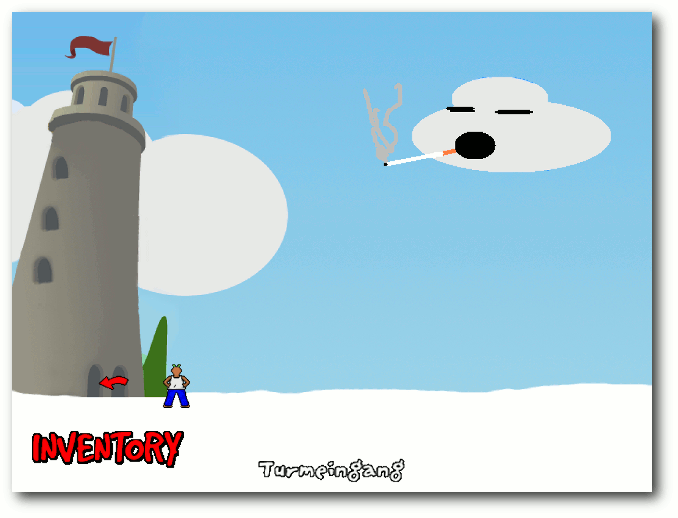

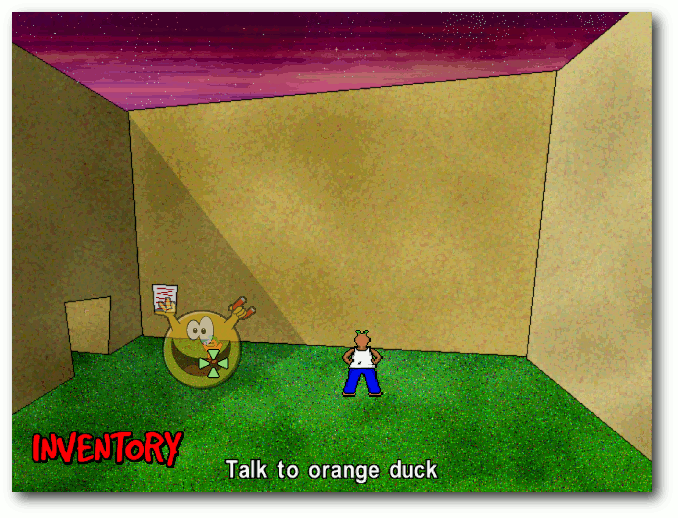

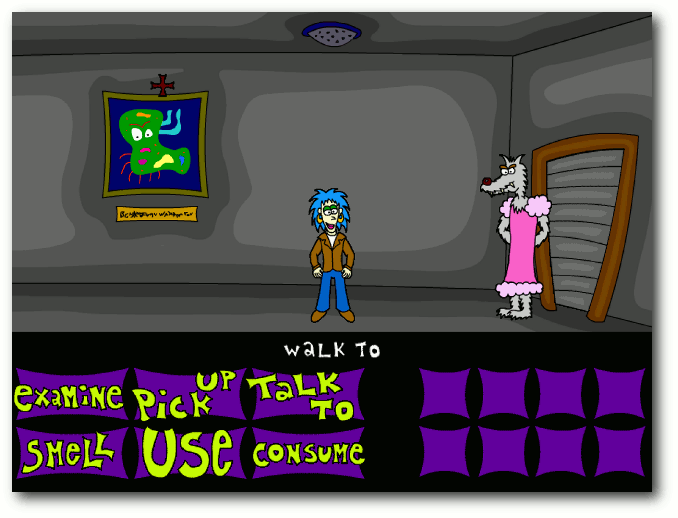

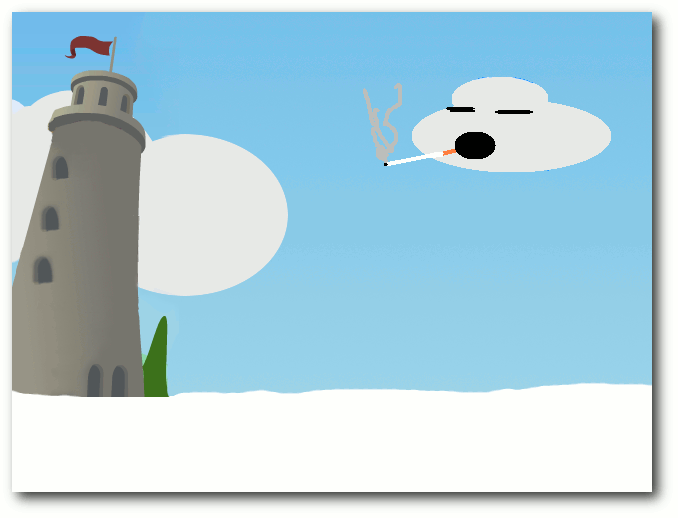

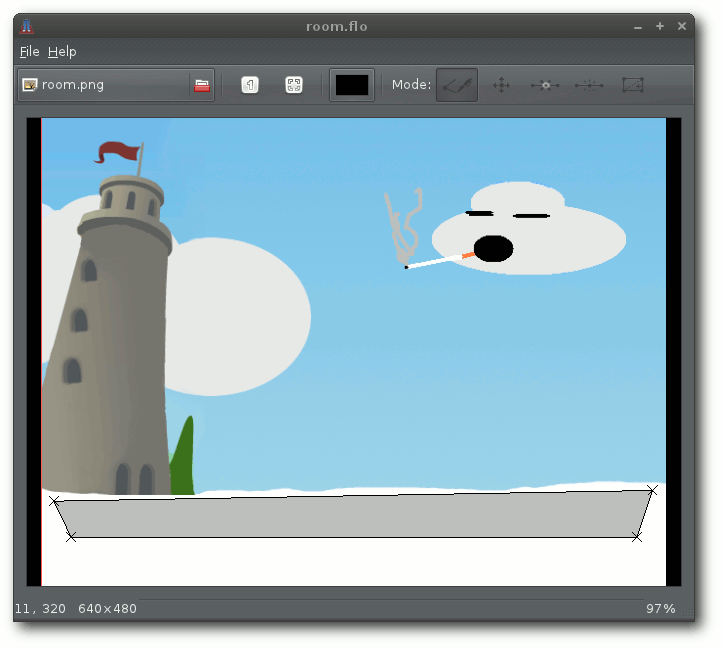

Grafikadventures entwickeln mit SLUDGE

Adventure-Fans wird der Name SCUMM sicherlich etwas sagen. SLUDGE ist eine freie Alternative dazu und bringt selbst noch Entwicklerwerkzeuge mit. Mit diesem System kann man auf jeder Plattform Grafikadventures entwickeln und spielen. Der Artikel soll einen kleinen Einblick in die ersten Schritte der Spielentwicklung mit SLUDGE geben. (weiterlesen)

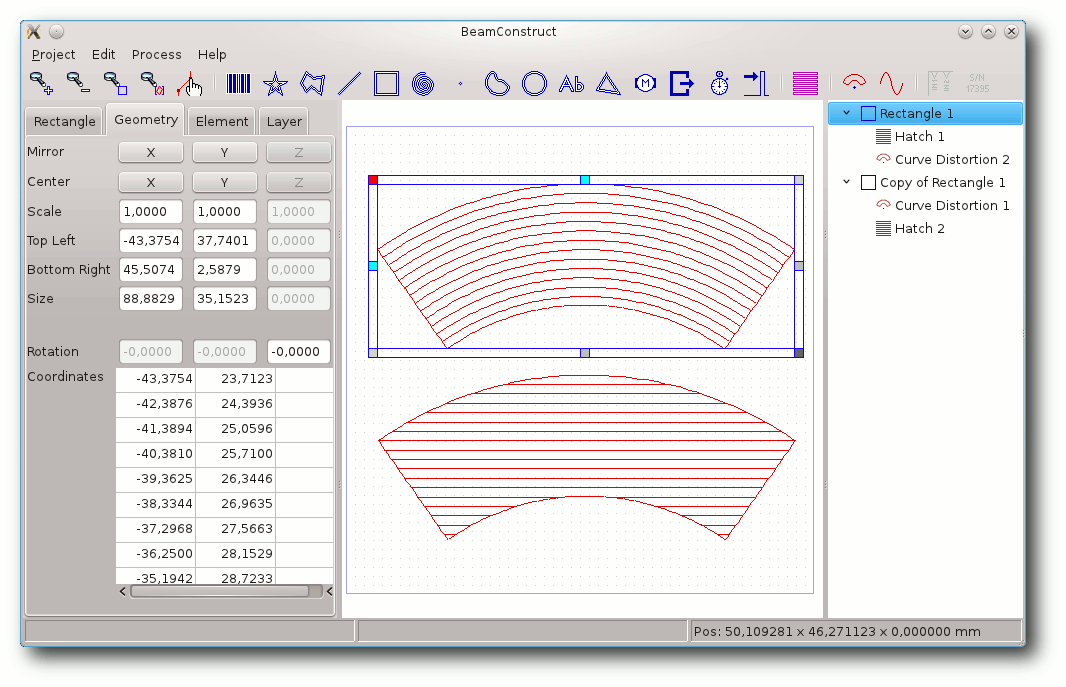

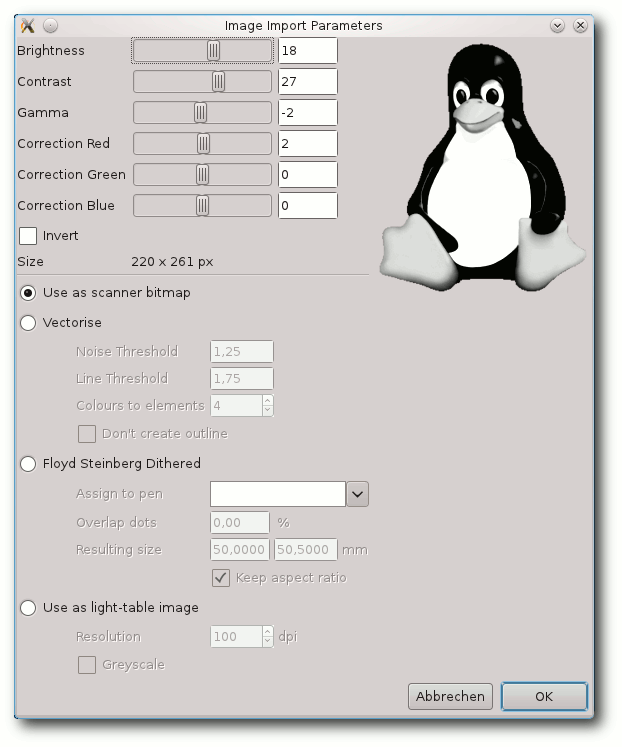

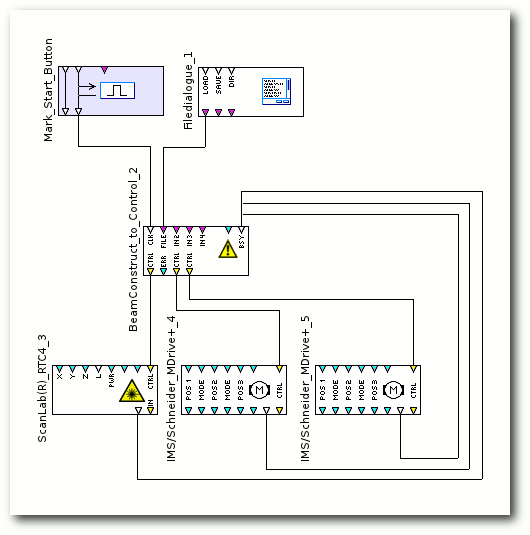

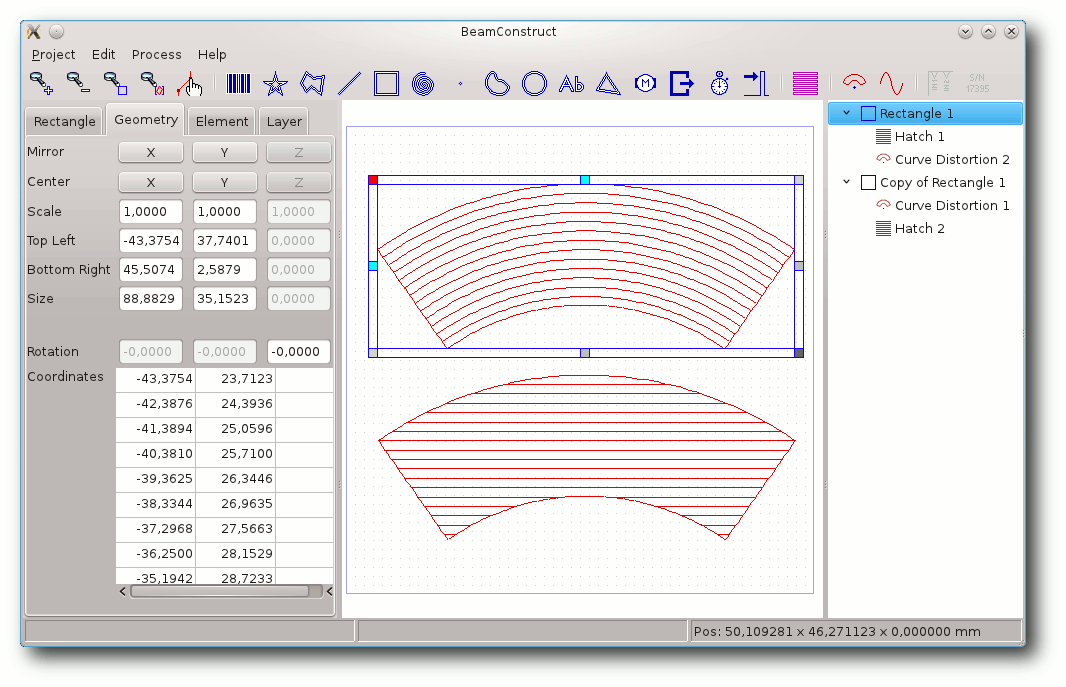

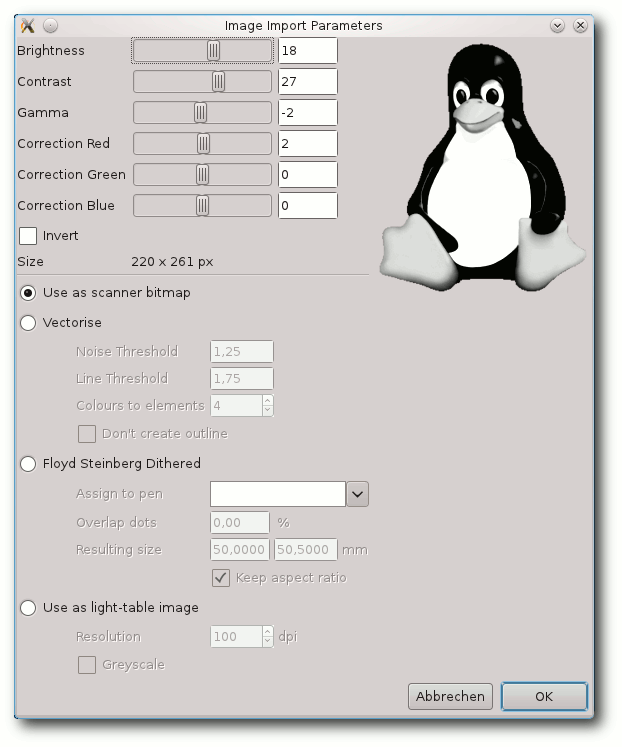

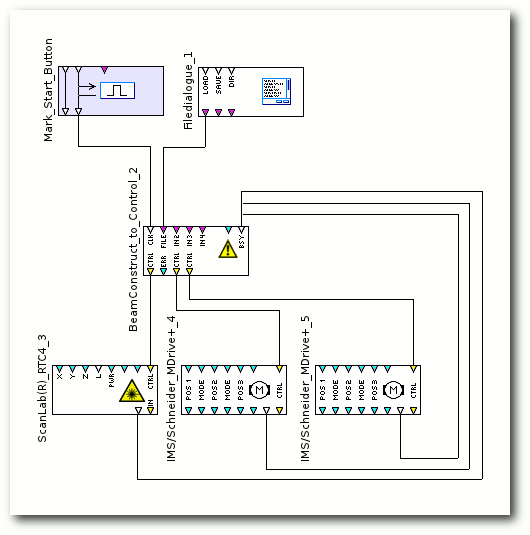

BeamConstruct – Linux in der Laserindustrie

Das bereits in vorangegangenen Artikeln vorgestellte OpenAPC-Softwarepaket hat mit der vor kurzem neu veröffentlichten Version 2 einige umfassend neue Funktionalitäten erhalten. Neben verschiedenen kleinen Detailverbesserungen, neuen Plug-ins, die zusätzliche Hardware unterstützen und einer kleineren Umorganisation des gesamten Paketes sticht eine Änderung deutlich heraus: Mit der Software BeamConstruct ist jetzt eine Applikation verfügbar, welche auf die Ansteuerung von Laserscannersystemen und generell auf Lasermarkieroperationen hin optimiert ist. (weiterlesen)

Zum Index

Linux allgemein

Pardus 2011.2

Unity

Der November im Kernelrückblick

Anleitungen

Python-Frameworks für HTML-Formulare

Grafikadventures entwickeln mit SLUDGE

PHP-Programmierung – Teil 3

Perl-Tutorium – Teil 4

Python – Teil 10: Kurzer Prozess

Software

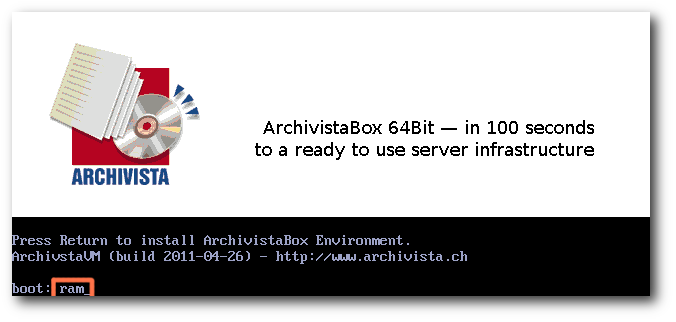

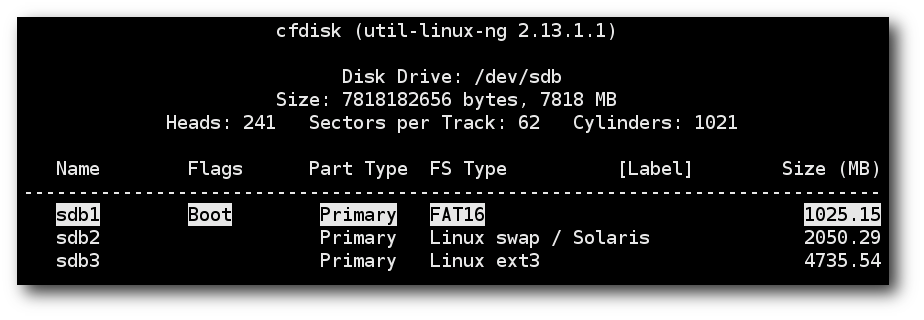

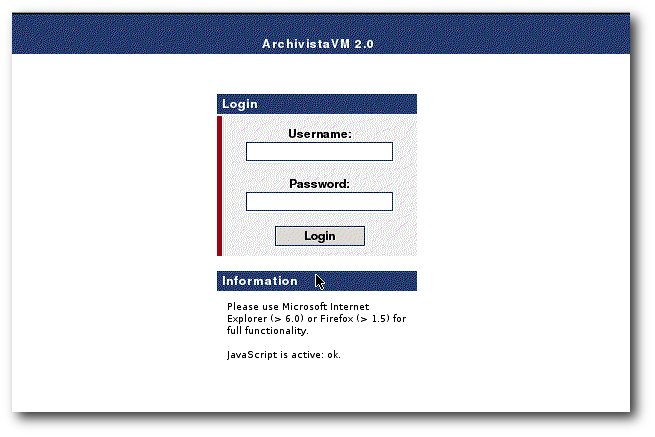

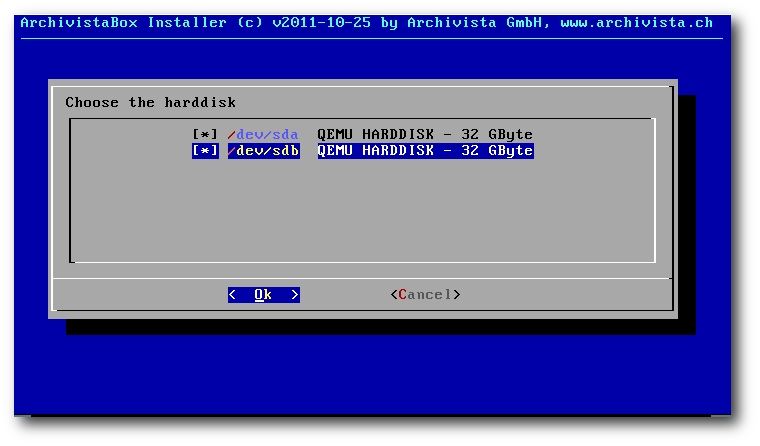

ArchivistaVM – Server-Virtualisierung

BeamConstruct

Community

Google Code-In

Rezension: LibreOffice – kurz & gut

Rezension: CouchDB

Magazin

Editorial

Jahresindex 2011

Vorschau

Konventionen

Impressum

Zum Index

Social Networking

Schon seit längerer Zeit ist freiesMagazin in sozialen Netzwerken vertreten, hat dies

aber nie groß bekannt gegeben. Grund dafür ist vor allem, dass die Konten nicht

offiziell von der freiesMagazin-Redaktion eingerichtet wurden, sondern von Fans

des Magazins.

Dennoch haben wir uns entschieden, auf unserer Webseite auf der rechten Seite

diese Konten aufzulisten, sodass man freiesMagazin leichter finden kann.

Neben prominenten Vertretern wie Facebook [1]

und Google+ [2]

ist freiesMagazin auch über Nachrichtendienste wie Twitter [3]

und identi.ca [4] erreichbar.

Auf diesen Seiten kann man, wie auch schon von der freiesMagazin-Webseite gewohnt,

Nachrichten und Updates zu verschiedenen Themen verfolgen.

Allerdings verwenden wir keine „Gefällt mir“-Buttons, da wir nicht mit den

Datenschutzbestimmungen der jeweiligen Dienste einverstanden sind.

Es ist uns bekannt, dass es von Heise eine Zwei-Klick-Lösung

gibt [5], die wir dennoch

nicht einsetzen werden, weil sich am eigentlichen Datenschutz der

Unternehmen nichts ändert.

Ende vierter Programmierwettbewerb

Am 30. November 2011 endete die Einsendefrist für die Teilnahme am

vierten freiesMagazin-Programmierwettbewerb, wie man bereits auf der

freiesMagazin-Webseite lesen konnte [6].

Die Kritik vom vorigen Wettbewerb hatten wir uns zu Herzen genommen und die

Aufgabe einfacher gestaltet, was bei Ihnen wohl sehr gut ankam. Es haben

erfreulicherweise mehr Teilnehmer ihre Bots eingeschickt als das bei irgendeinem

Programmierwettbewerb vorher der Fall war.

Insgesamt traten so 20 Bots gegeneinander an.

In den nächsten Tagen findet dann die Ausführung des Wettbewerbs

statt, so dass wir die Gewinner noch in der Vorweihnachtszeit auf der

freiesMagazin-Webseite und dann in der Januar-Ausgabe im Magazin bekannt geben können.

Index 2011

Wie jedes Jahr gibt es in der letzten Ausgabe des Jahres einen

Jahresindex.

Der freiesMagazin-Jahresindex 2011 steht auch auf der Webseite im Archiv [7]

zum

Download bereit.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] https://www.facebook.com/freiesMagazin

[2] https://plus.google.com/u/0/113071049781738007718

[3] https://twitter.com/#!/freiesmaga_open

[4] https://identi.ca/group/freiesmagazin

[5] http://www.heise.de/extras/socialshareprivacy/

[6] http://www.freiesmagazin.de/20111201-vierter-programmierwettbewerb-beendet

[7] http://www.freiesmagazin.de/archiv

Das Editorial kommentieren

Zum Index

von Hans-Joachim Baader

Obwohl die Linux-Distribution Pardus vom türkischen Staat gefördert

wurde, richtet sie sich an ein internationales Publikum. Sie nutzt

diverse Eigenentwicklungen, die sie deutlich von anderen abheben.

Grund genug, einmal einen näheren Blick zu riskieren.

Redaktioneller Hinweis: Der Artikel „Pardus 2011.2“ erschien erstmals bei

Pro-Linux [1].

Vorwort

Was fällt einem beim Stichwort Pardus ein? Wer sich daran erinnert,

dass in diesem Jahr Pardus 2011 sowie die Updates Pardus 2011.1 und

Pardus 2011.2 veröffentlicht wurden, dem sind vielleicht Begriffe

wie das Installationsprogramm YALI (Yet Another Linux Installer),

die eigenständige Paketverwaltung PISI und das Programm Kaptan zur

individuellen Anpassung des Desktops (Pardus setzt dabei ganz auf

KDE) keine Unbekannten. Durch diese Eigenentwicklungen unterscheidet sich

Pardus deutlich von anderen Distributionen wie z. B. Debian, Fedora,

Kubuntu, Mageia/ Mandriva oder Opensuse, obwohl der größte Teil der

Software doch wieder identisch mit den anderen ist. Doch das ist

noch nicht alles, wie der Artikel zeigen wird.

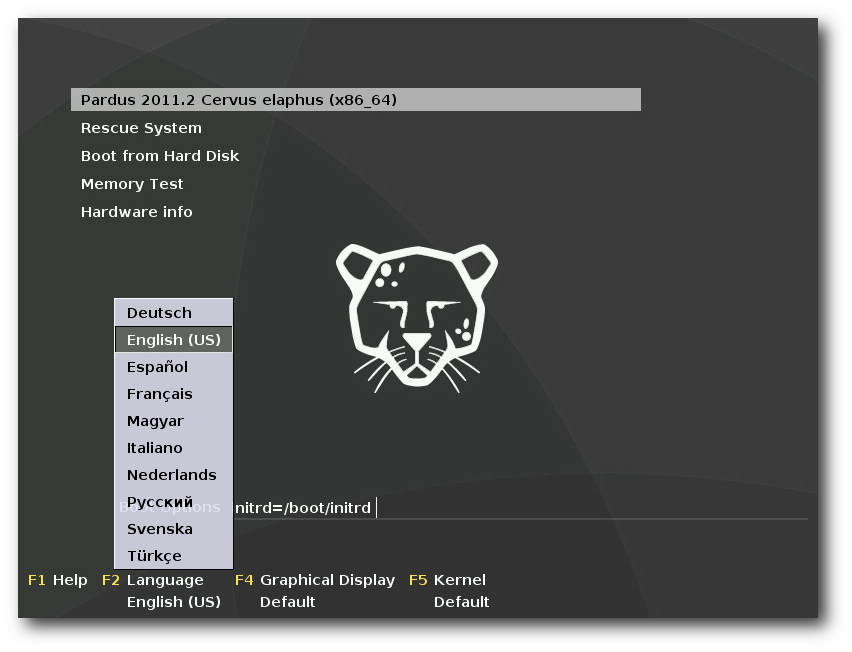

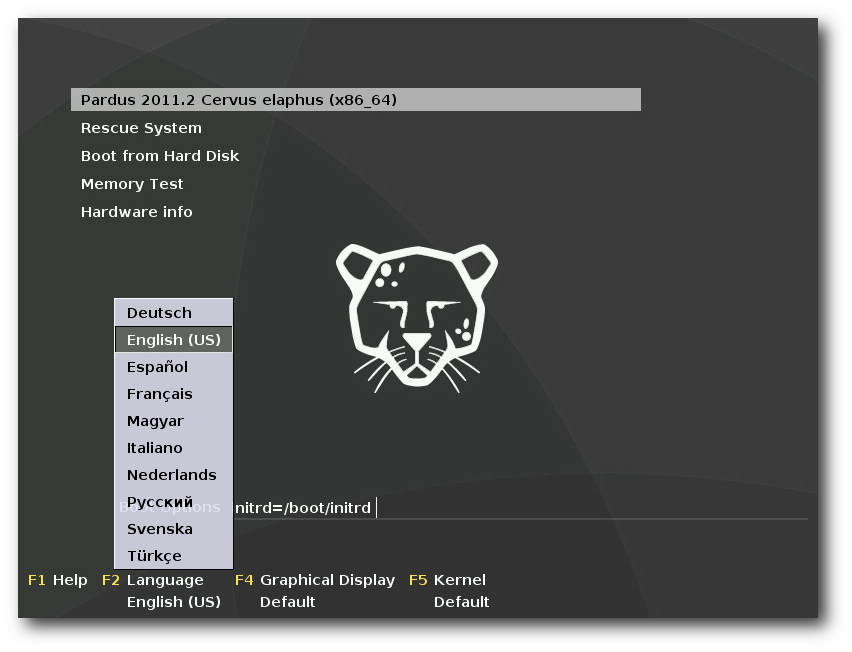

Booten von der DVD.

Installation

Pardus 2011.2 ist auf die x86-Architektur beschränkt. Es steht in 32-

und 64-Bit zur Verfügung und kann frei von der Webseite [2]

heruntergeladen werden. Neben Installations-DVDs stehen zum

Ausprobieren auch Live-DVDs zur Verfügung. Natürlich ist es auch

möglich, mit den DVD-Images einen bootfähigen USB-Stick zu

konstruieren.

Die Installation läuft grafisch ab und erinnert deutlich an Fedora.

Möglicherweise stammt das Installationsprogramm YALI ja von Anaconda

ab, aber über die Hintergründe ist mir nichts bekannt. Schon beim

Bootprompt kann man die Sprache wählen und beispielsweise auf

Deutsch umschalten. Die deutsche Übersetzung war wohl früher ein

Kritikpunkt, ist inzwischen aber bis auf Kleinigkeiten gut.

Die Installation erlaubt zuerst die Auswahl der

Tastatureinstellungen, dann die lokale Zeit und Zeitzone, und kommt

dann zur Partitionierung. Hier lassen sich, wie inzwischen üblich,

die Optionen Gesamten Speicher verwenden, Vorhandenes System

verkleinern, Freien Speicherplatz verwenden und Manuelle

Partitionierung wählen.

Danach kann man den Bootmanager konfigurieren oder einfach bei den

Standardeinstellungen bleiben. Das war es auch schon, da einige

weitere Einstellungen erst nach der jetzt beginnenden Installation

vorgenommen werden.

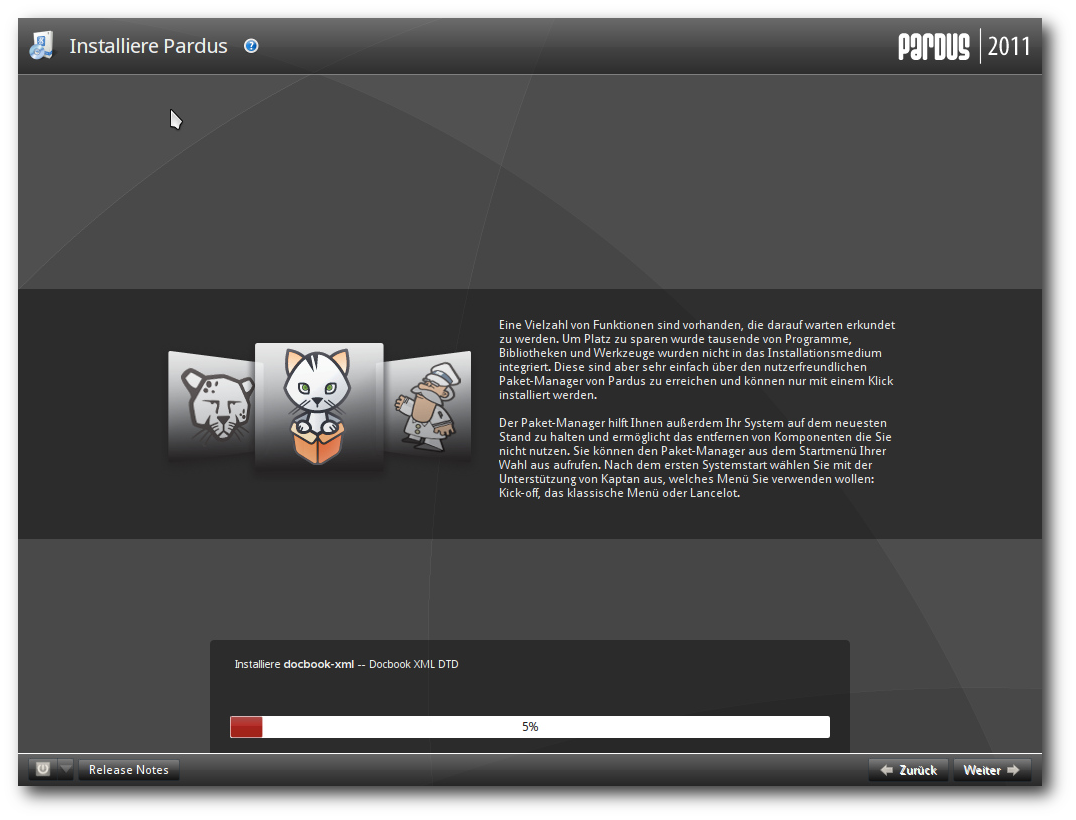

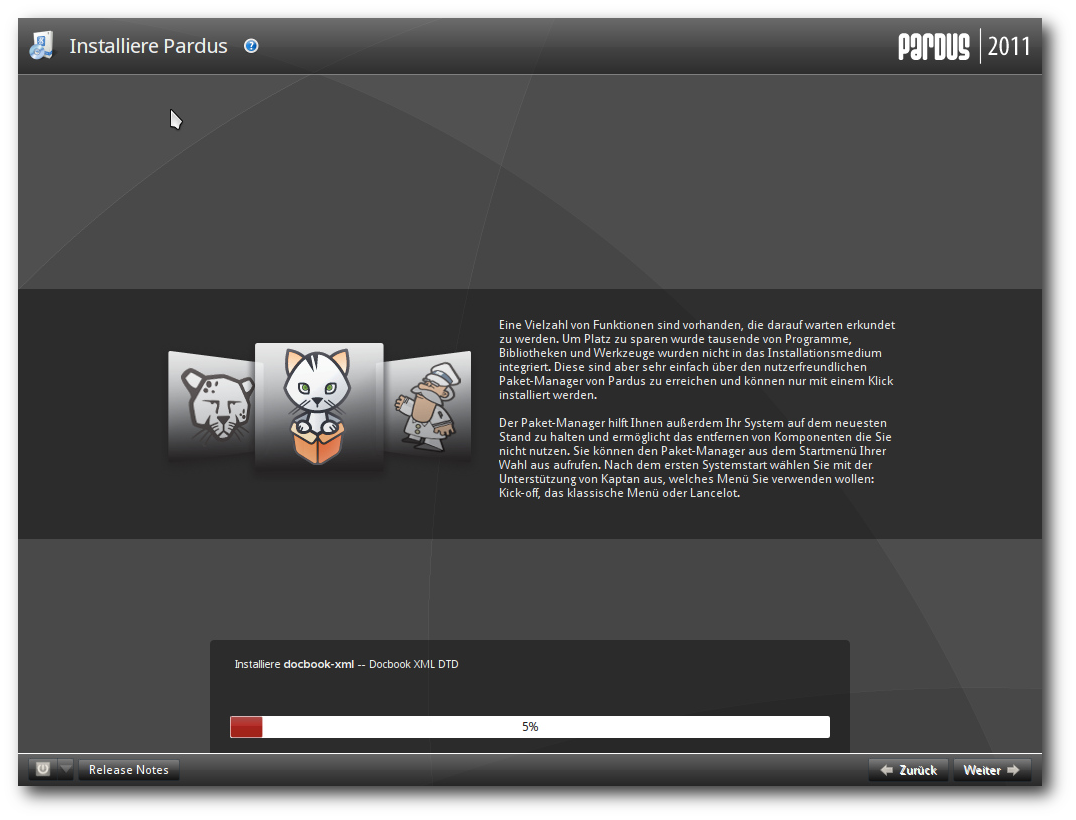

Pardus wird installiert.

Nach der erfolgreichen Installation, die eine Weile dauert, wird das

System hochgefahren und die weitere Konfiguration vorgenommen. Vor

allem erfolgt nun die Festlegung des Root-Passworts und das Anlegen eines

Benutzers für das grafische Log-in. Nun startet KDE zum ersten Mal.

Das ist der Auftritt von Kaptan, einem Wizard, der in wenigen

Schritten die Anpassung des Desktops ermöglicht. Nach der

Einstellung der Maus kann man ein Theme und die Anzahl der

virtuellen Desktops einstellen,

danach einen Menüstil wählen, dann

ein Hintergrundbild und ein Benutzerbild aussuchen, Einstellungen

zum Update vornehmen und schließlich, allerdings optional und

standardmäßig ausgeschaltet, sein Hardwareprofil an den Distributor

senden.

Kaptan hilft beim Einrichten des KDE-Desktops.

Ausstattung

Die Standardinstallation von Pardus 2011.2 bietet etwa 960 Pakete

auf. Enthalten sind unter anderem KDE SC 4.6.5 zusammen mit KDE PIM

4.4.11, LibreOffice 3.4.3, Clementine 0.7.1, Digikam 1.9.0, Firefox

5.0, GIMP 2.6.11, NetworkManager 0.8.5.91, GStreamer 0.10.32.4,

FFmpeg 0.6.1, PulseAudio 0.6.1, Bash 4.1, OpenSSH 5.6, lcms 1.19,

Samba 3.5.10, Python 2.7.1, Perl 5.12.2, Ruby 1.8.7, Lua 5.1.4 Tcl

8.5.10, X-Server 1.9.5 und Kernel 2.6.37.6. Der Standard-Browser ist

Firefox, aber Konqueror steht ebenfalls zur Verfügung.

Mehr als 3700 weitere Pakete sind aus den Online-Archiven

erhältlich, darunter die Desktopumgebungen Enlightenment, LXDE, Xfce

und GNOME 2.32, Entwicklungs- und Server-Werkzeuge sowie Spiele.

Darüber hinaus gibt es hunderte von Paketen, die von der

Gemeinschaft erstellt wurden und in zusätzlichen Repositorien

verfügbar sind. Die Distribution hat damit einen ähnlichen Umfang

wie andere, ist in der Standardinstallation recht aktuell und bringt

alles mit, um ein weitgehend kompatibles Linux darzustellen.

Betrieb

Pardus 2011.2 startet recht flott – 25 Sekunden waren es bis zum

Log-in-Fenster. Für eine durchgehende grafische Darstellung wird

Plymouth verwendet. Der Speicherverbrauch ist mit über 450 MB nach

dem Start recht hoch. Ein Grund dafür ist die in Python geschriebene

Paketverwaltung, aber auch Akonadi trägt einiges bei. Bei längerem

Betrieb erhöht sich der Speicherbedarf noch, da sowohl knotify4 als

auch die als Icon laufende Paketverwaltung permanent CPU-Leistung

und Speicher verbrauchen. Im Laufe eines einzelnen Tages ist der

Zuwachs aber noch vernachlässigbar. Die standardmäßig installierte

KDE-Oberfläche sieht im Wesentlichen aus wie bei anderen

Distributionen.

Will man einen Dienst starten, so sucht man aus Gewohnheit im

Verzeichnis /etc/init.d nach einem entsprechenden Skript. Bei

Pardus findet man nur leere Verzeichnisse vor und stellt überrascht

fest: Pardus benutzt ein ganz anderes Init-System. Weder das

traditionelle SysV-Init noch Upstart noch Systemd steuern den

Betrieb bei Pardus. Stattdessen kommt das selbstentwickelte

Init-System Mudur (von türkisch Müdür, Direktor) zum Einsatz. Es ist

in Python geschrieben, wovon man sich unter /sbin/mudur.py selbst

überzeugen kann. Das Programm wird offenbar von /etc/inittab

gesteuert und weitere Steuerdateien liegen unter etc/mudur. Die zu

startenden Dienste werden dabei durch Dateien definiert, deren Name

den Dienst angibt und deren Inhalt keine Rolle zu spielen scheint,

weshalb sie leer sind.

Multimedia im Browser und auf dem Desktop

Die Softwarepatente in den USA berühren Pardus als europäische

Distribution nicht. Daher sind alle wichtigen freien Codecs im

Standardumfang enthalten, gleichgültig ob sie von Patenten belastet

sind oder nicht. Dadurch ergibt sich unter Pardus die ungewohnte

Situation, dass sich alle relevanten Medienformate ohne

Nachinstallation oder Konfiguration abspielen lassen. In der Tat

werden Dateien, die man mit dem Dateimanager Dolphin öffnet, immer

dem korrekten zuständigen Programm übergeben. In dieser Hinsicht ist

Pardus perfekt.

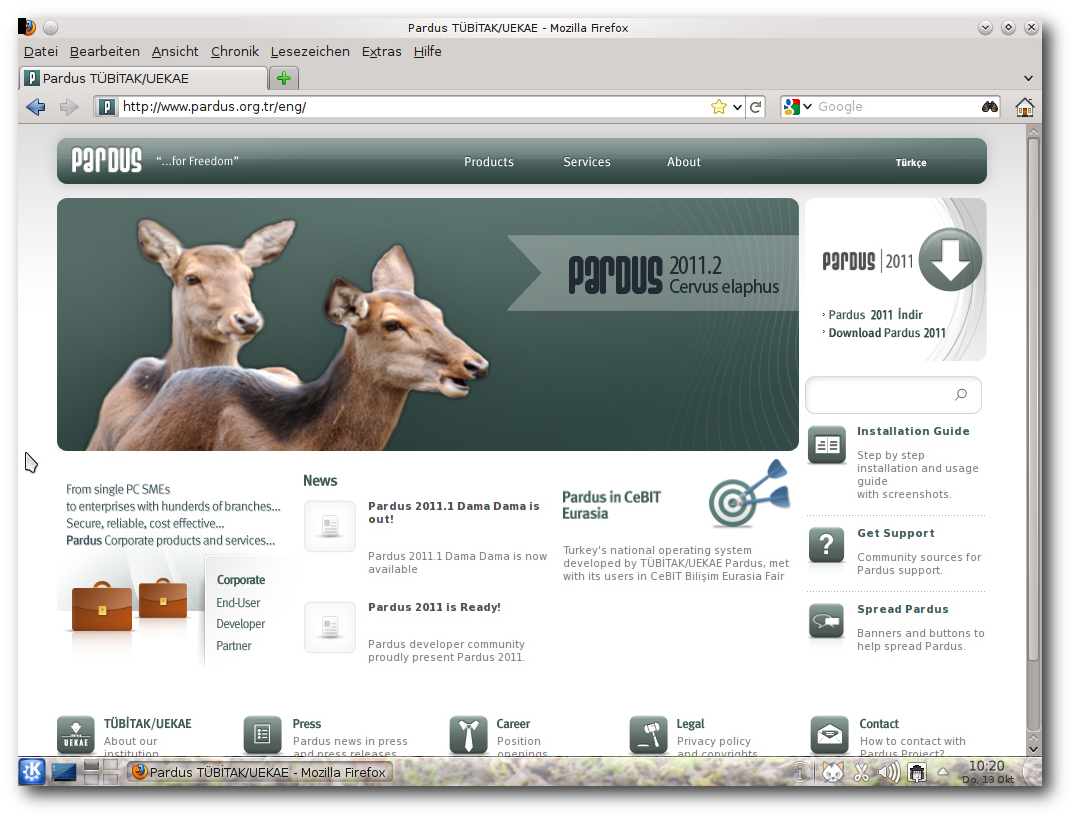

Die Perfektion setzt sich in Firefox fort. Videos von verschiedenen

Webseiten funktionierten in allen getesteten Fällen dank der

vorinstallierten Plugins, zu denen auch Java und Adobe Flashplayer

11 zählen. In Konqueror scheint der Flashplayer aber leider nicht zu

funktionieren, und andere Videos können nur in externen Playern

abgespielt werden, was allerdings auch problemlos funktioniert.

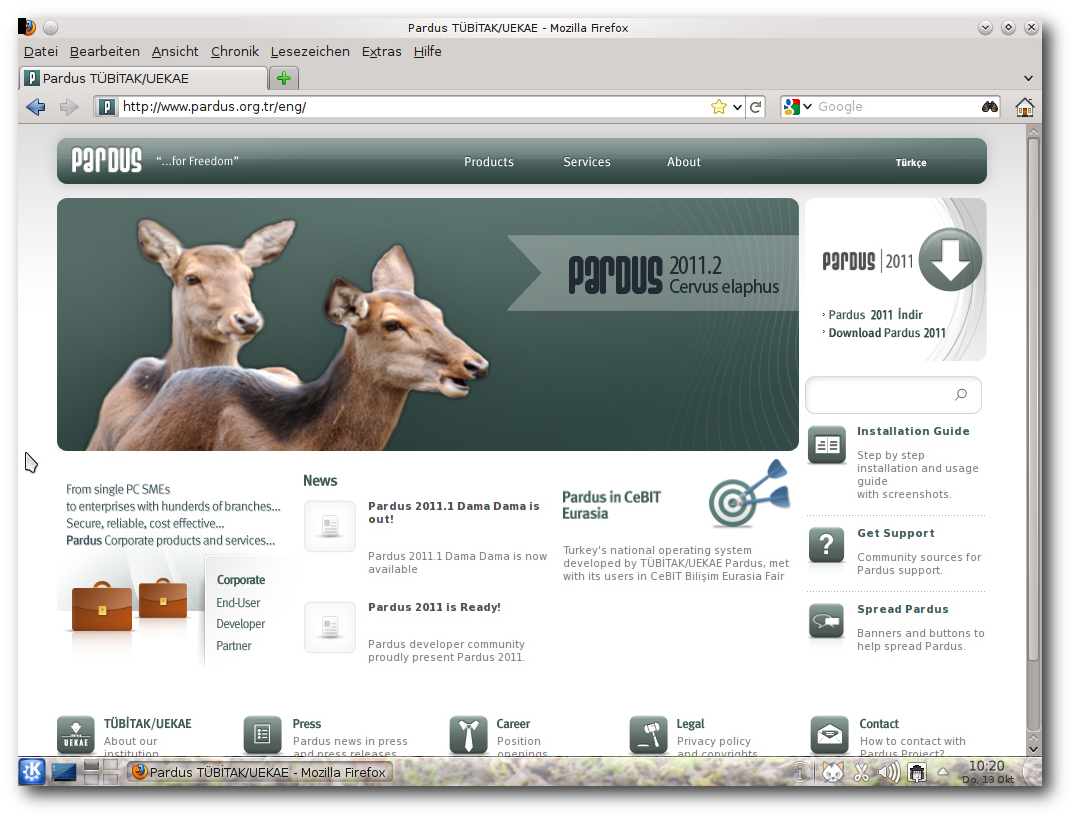

Firefox mit der Pardus-Homepage.

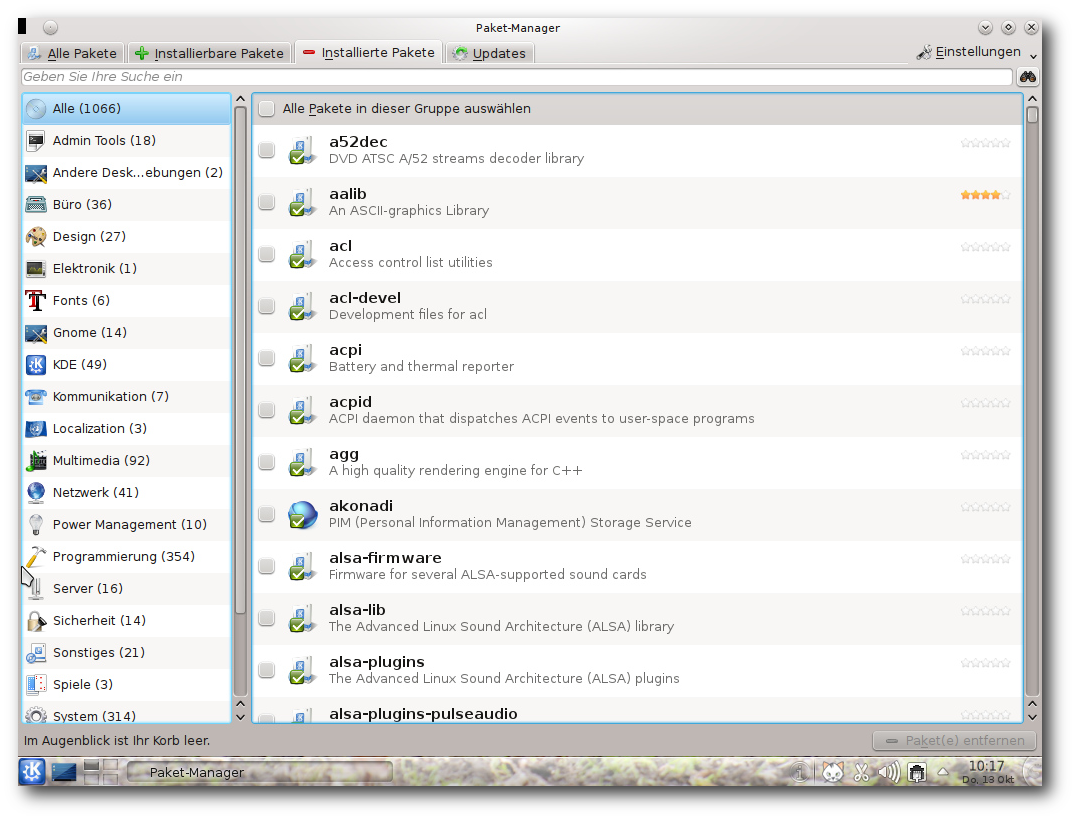

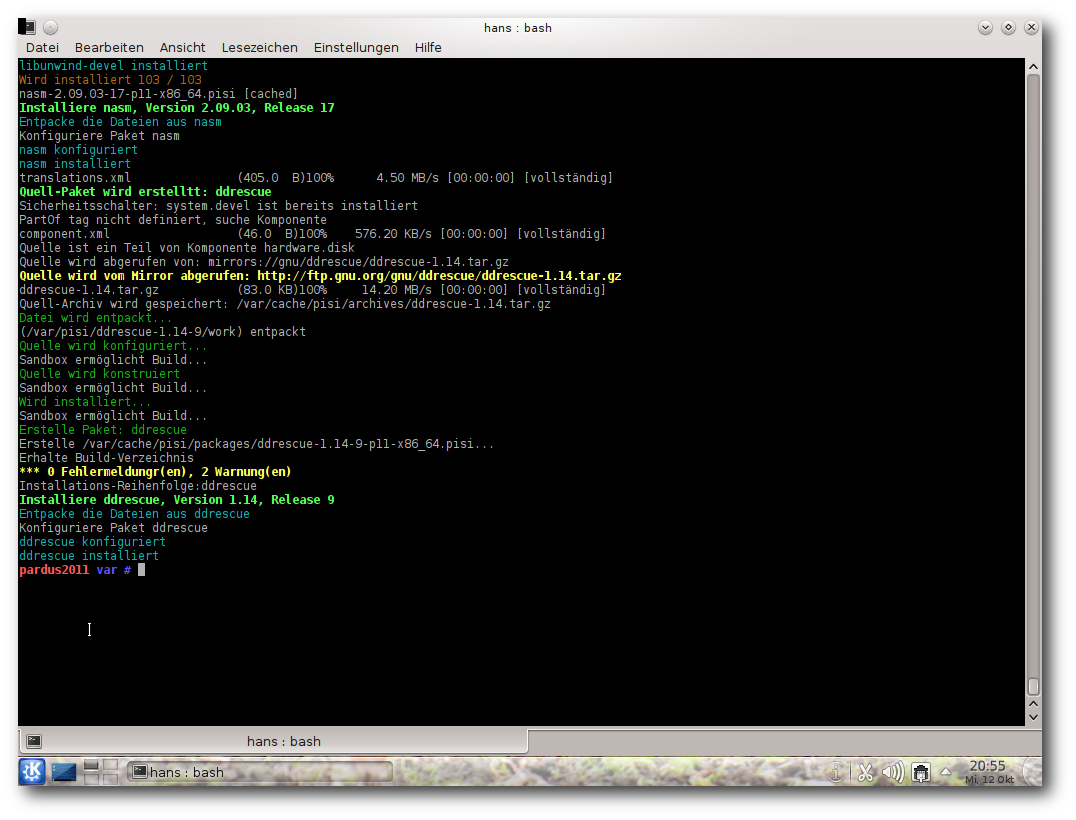

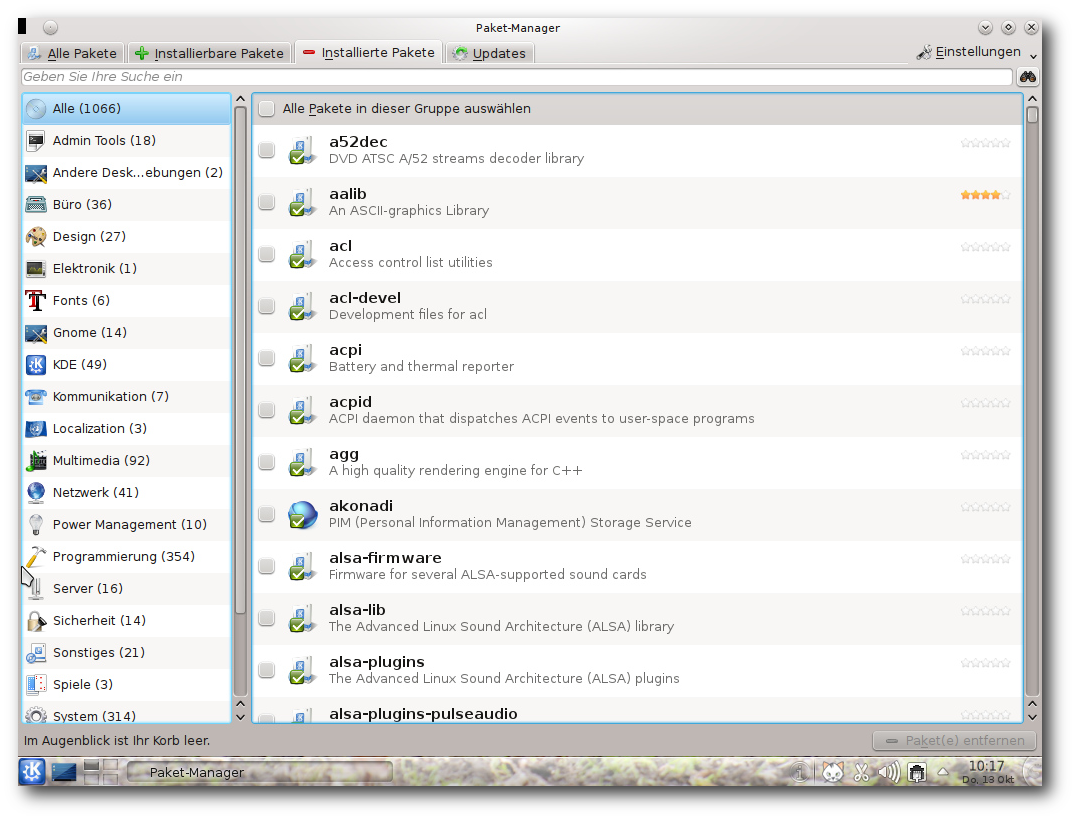

Paketverwaltung und Updates

Die mitgelieferte grafische Paketverwaltung, einfach Paket-Manager

genannt, kommt einem bekannt vor, erinnert sie doch ein Stück

weit

an KPackage, Synaptic oder andere entsprechende Programme. Es ist

ein Programm, das die Aufgaben Konfiguration, Aktualisierung und

Hinzufügen oder Entfernen von Paketen in einem Werkzeug vereinigt.

Es fällt zunächst nicht auf, dass im Hintergrund bei Pardus etwas

ganz anderes arbeitet als bei Fedora oder Ubuntu. Denn auch die

Paketverwaltung ist eine Eigenentwicklung, und auch sie wurde in

Python implementiert. Das Hauptwerkzeug der Paketverwaltung heißt

Pisi [3], was für

„Packages Installed Successfully, as intended“ steht. Es ist weder

zu RPM noch zu Debian-Paketen kompatibel, die Gründe dafür sind auf

der Pisi-Projektseite nachzulesen. Das Kommandozeilenprogramm „pisi“

erinnert in seiner Syntax an Zypper von openSUSE, enthält aber auch

Elemente von Gentoo, denn der Befehl pisi em(erge) lädt

Quellcode-Pakete aus den Repositories herunter, kompiliert und

installiert sie. Damit das funktioniert, muss man lediglich das

passende Quellcode-Depot als Paketquelle hinzufügen. Um alles andere

kümmert sich Pisi.

Besonders interessant dürfte das sein, um Pakete

zu installieren, die für andere Pardus-Versionen konstruiert wurden.

Die Paketverwaltung.

Pisi spielt zusammen mit dem Konfigurationssystem

COMAR [4]

(eigentlich ÇOMAR), dem es die gesamte Konfiguration überlässt.

COMAR, eine weitere Neuentwicklung, steht für Configuration Manager.

COMAR arbeitet auch mit dem Init-System Mudur zusammen.

Eine bemerkenswerte Erweiterung von Pisi ist

Pisibul [5], das Software aus

den Quellen kompiliert und paketiert. Leider ist die letzte Version

0.24 schon vier Jahre alt. Sie lässt sich zwar installieren,

funktioniert aber nicht mehr, da sie wohl nicht an KDE 4 angepasst

wurde.

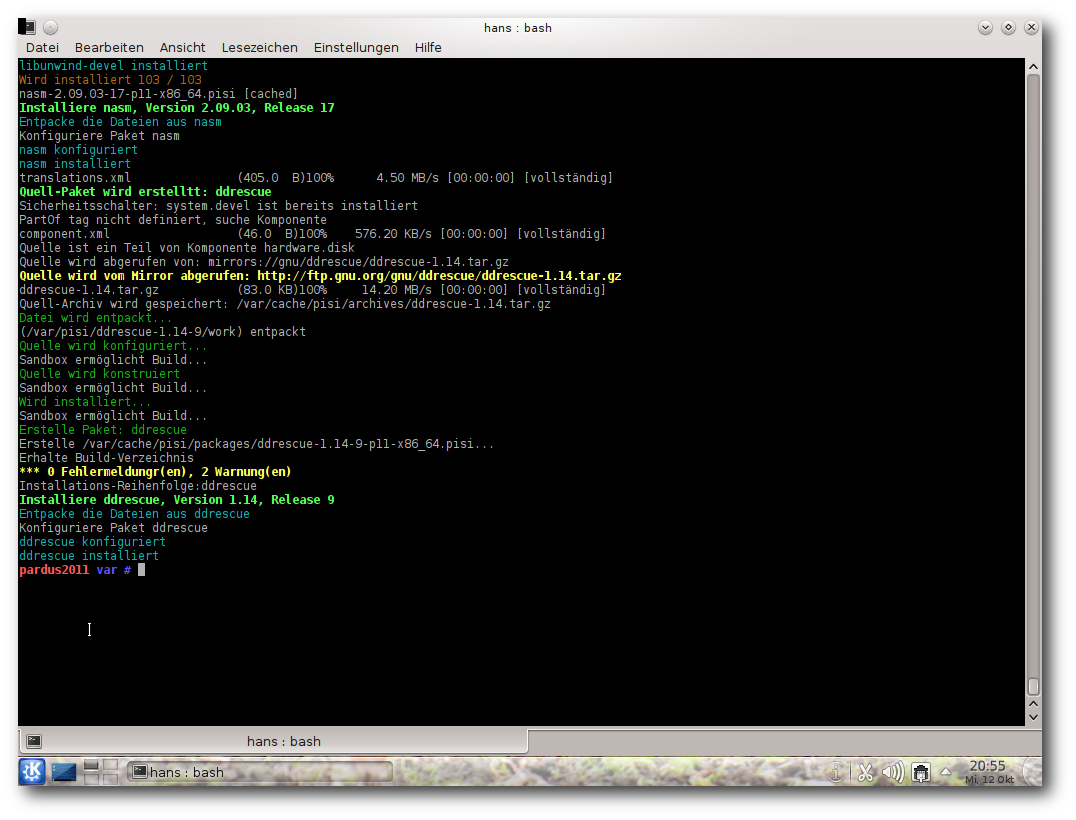

pisi emerge in Aktion.

Fazit

Pardus 2011.2 ist eine bemerkenswert frische Distribution, die einen

Test wert ist. Ihr größter Vorteil ist vielleicht, dass sie erst ab

2003 entstand und nach den ersten Anfängen dazu überging, traditionelle

Paradigmen zu überdenken und durch Neuimplementierungen zu ersetzen.

Alles, was Pardus von anderen Distributionen unterscheidet, wurde in

Python implementiert, was den Entwicklern zufolge zu höherer Geschwindigkeit

und besserer Wartbarkeit führt. Zudem sind bestimmte, in anderen

Programmiersprachen häufige Fehler in Python ziemlich unwahrscheinlich,

und so läuft das System auch sehr stabil und zuverlässig.

Pardus ist nicht die aktuellste Distribution, aber gerade die eher

spärlichen Updates und die lange Lebensdauer der einzelnen Versionen

werden von vielen Benutzern eher als Vorteil denn als Nachteil

gesehen. Nur alle ein bis zwei Jahre erscheint eine ganz neue

Version. Der Umfang der Distribution ist, wenn man die

Online-Repositorien einbezieht, ausreichend, und zusätzliche

Repositorien von Anwendern und Anwendergruppen sowie die

Möglichkeit, Pakete aus dem Quellcode zu erstellen, erweitern das

Angebot erheblich.

Links

[1] http://www.pro-linux.de/artikel/2/1532/pardus-20112.html

[2] http://www.pardus.org.tr/en

[3] http://www.pardus.org.tr/eng/projects/pisi/index.html

[4] http://www.pardus.org.tr/eng/projects/comar/index.html

[5] http://en.pardus-wiki.org/Pisibul

| Autoreninformation |

| Hans-Joachim Baader (Webseite)

befasst sich seit 1993 mit Linux. 1994 schloss er sein

Informatikstudium erfolgreich ab, machte die Softwareentwicklung

zum Beruf und ist einer der Betreiber von Pro-Linux.de.

|

| |

Diesen Artikel kommentieren

Zum Index

von Stephan Scholz

Seit Ubuntu 11.04 (Natty Narwhal) ist die Benutzeroberfläche Unity

fester Bestandteil des Betriebssystems. War ein Wechsel zu

Ubuntu-Classic hier noch möglich, hat sich die Lage nach einer

Standardinstallation von Ubuntu 11.10 geändert: Nun kann man (nur

noch) zwischen der 3D- und der 2D-Variante von Unity auswählen –

es folgt ein Blick auf die Neuerungen.

Der Anmeldebildschirm

Unter dem GNOME Display Manager verhält sich der Anmeldevorgang wie

gewohnt. Ab der Ubuntu-Version 11.10 verwendet Ubuntu den Display

Manager LightDM.

Mit diesem ist es möglich, die Barrierefreiheit zu gewährleisten, z. B. mittels

Bildschirmtastatur oder Bildschirmlupe.

Diese Tools sind für Tablet-PCs besonders wichtig, da diese meist

über keine Tastatur verfügen.

Der Startbildschirm

Nach dem Anmeldevorgang befindet man sich auf der ersten

Arbeitsfläche.

Von dort aus gelangt man über die linke Leiste (Starter) in das

Unity Menü (Dash), in die vorgegebenen Programme und zum Mülleimer.

Am oberen Rand befinden sich Menüs zum schnellen Zugriff auf das

Me-Menü, auf Hardware-Dienste (wie Audio- und

Netzwerk-Einstellungen) und andere Dienste eines modernen

System-Trays. Eine große Neuerung, die mit Unity eingeführt wurde,

ist, dass Programme ihre Menüleiste in diesen oberen Rand legen.

Über diesen Schnellzugriff gelangt man beim Darüberfahren mit der

Maus, wenn kein Programmfenster aktiv ist, zu den aus GNOME 2.3

bekannten Verknüpfungen zu den „Persönlichen Ordnern“.

Übersicht über die Dash.

Der Starter – Launcher

Der Starter ist ein zentrales Instrument zur Orientierung auf der

Unity-Oberfläche. Mit Hilfe des Starters greift man schnell auf

Programme, Dateien und das Unity-Menü (Dash) zu.

Er wurde für kleine Desktops entwickelt und dient der leichten

Übersicht auf der Oberfläche.

Anders als bei bekannten Docks ist der Starter schon vollständig

vorkonfiguriert, sodass nur die enthaltenen Programme

ausgetauscht, entfernt und neue hinzugefügt werden können.

Über einen Rechtsklick auf ein Programm im Starter kann der Benutzer

bestimmen, ob das Programm geschlossen, gestartet oder im Starter

verankert werden soll.

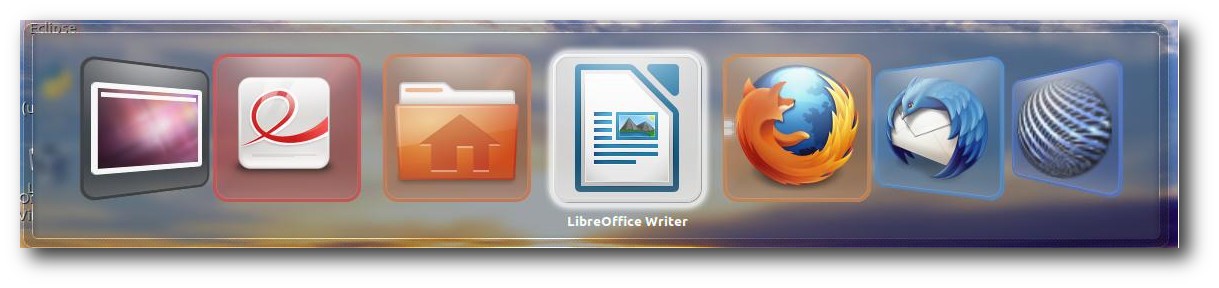

Das Unity-Menü – Dash

Zum Unity-Menü gelangt man über einen Klick auf das Ubuntu-Symbol

oberhalb des Starters (ab 11.10 innerhalb desselben). Das Unity-Menü

bietet die Möglichkeit, auf Programme, Ordner und Dateien thematisch

und alphabetisch sortiert zugreifen zu können.

Die Suchfunktion durchsucht Dokumente und Programme, ob diese thematisch,

namentlich oder inhaltlich (bei Textdateien) in das Suchraster passen. Die

Größe der Dash kann entweder per Shelleingabe (Ubuntu 11.04) oder

ab Ubuntu 11.10 über Icons geändert werden.

Programme und Ordner

Die Unity-Oberfläche orientiert sich stark an modernen Oberflächen,

ähnlich wie bei den

Mac-OS-X-Betriebssystemen.

Wie bereits beschrieben sind die Menüleisten der Anwendungen nicht

wie gewohnt im Programmfenster, sondern am oberen Rand zu finden.

Eine weitere Neuerung ist, dass die Größe der Programmfenster über

das Schieben an den linken, rechten und oberen Rand teilweise

oder vollkommen maximiert wird.

Das Software-Center

Ab Ubuntu 11.10 wurde der Paketmanager Synaptic komplett durch das

Software-Center ersetzt. Das Nachinstallieren von Synaptic ist

trotzdem möglich.

Das Software-Center bietet vor allem für Einsteiger eine

übersichtliche Oberfläche. Die Suche nach geeigneten Programmen

wird durch Icons und Programmbeschreibungen deutlich verbessert.

Es ist möglich, nach einer Installation das installierte Programm

direkt im Launcher als Standard zu integrieren. Über das Tool

quickly können nun auch eigene Programme in die Ubuntu-Repositories

geladen werden. Weitere Informationen findet man auf der Developer

Seite von Ubuntu [1].

Die Systemeinstellungen

Neu ist ab Ubuntu 11.10 die zentrale Verwaltung der

Systemeinstellungen. Über diese gelangt man zu den wichtigsten

Konfigurationen.

Man findet die Systemeinstellungen im Sitzungsmenü in der

rechten oberen Ecke.

Weitere Neuerungen

Programme wie Mozilla Firefox, Evolution (Ubuntu 11.04), Thunderbird

(Ubuntu 11.10) und Banshee sind in Unity vollständig integriert.

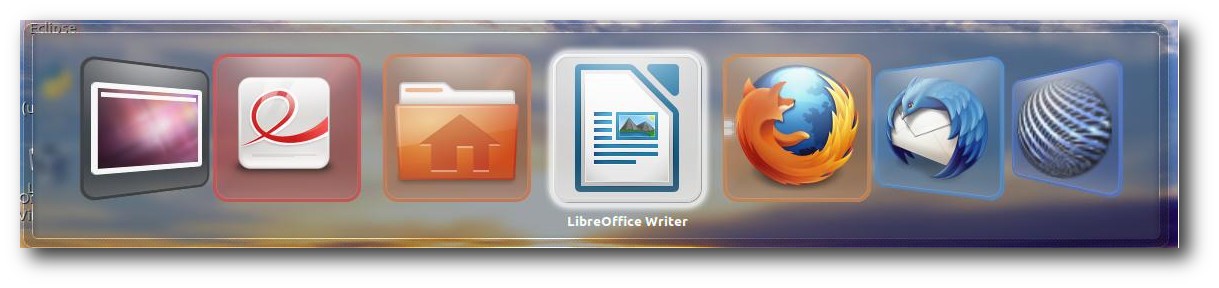

Darstellung des Umschaltens bei Unity-3D.

Durch diese Integration wird beispielsweise eine neue E-Mail im

Message-Menü blau dargestellt. Mit Ubuntu 11.10 kann man die Unity-Oberfläche auch auch ohne

3D-Beschleunigung einsetzen.

Unity-2D verfügt zwar über die gleichen Tools wie Unity-3D, jedoch

wurden die grafischen Effekte, bei denen man eine 3D-Beschleunigung

braucht, herausgenommen.

So wird etwa der Starter, die Dash und das Umschalten per Alt und

Umschalt-Taste klobig dargestellt.

Zusammenfassung

Die Unity-Oberfläche ist, ähnlich wie die GNOME-Shell, ein

grafischer Aufsatz auf die GNOME 2.3 und GNOME 3.0 Oberfläche.

Außerdem verwendet Unity, um die vielen Grafikeffekte verarbeiten zu

können, den Fenstermanager Compiz.

Somit macht die Kombination aus GNOME-Oberfläche, Compiz und

Canonical als Entwicklerteam Unity bedienungsfreundlich und fit für

die Zukunft, besonders um proprietären Betriebssystemen die Stirn zu

bieten.

Diese Bedienungsfreundlichkeit geht jedoch zu Lasten von

Ubuntu/Linux-Nutzern, die die neue Oberfläche als zu umständlich

betrachten.

Möchte

man beispielsweise tiefgreifende Änderungen an Unity

vornehmen, muss man Dconf oder CompizConfig benutzen [2].

Außerdem ergeben sich im Detail Fehler, wie das fehlende Hinzufügen

von eigens erstellten wechselnden Hintergründen

(Slideshow-Wallpapers).

Falls man Hilfe, Informationen oder aktuelle Neuigkeiten zu Ubuntu

und Unity sucht sind die Internetseiten von „OMG! Ubuntu!“ [3] und „ubuntuusers“ [4]

hilfreich.

Links

[1] http://developer.ubuntu.com/

[2] http://askubuntu.com/questions/29553/how-can-i-configure-unityubuntuusers.de

[3] http://www.omgubuntu.co.uk/

[4] http://ubuntuusers.de

| Autoreninformation |

| Stephan Scholz

arbeitet seit 2010 ausschließlich mit Linux bzw.

Ubuntu. Er interessiert sich für innovative Linux-Technologien.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der fortwährend weiterentwickelt wird. Welche Geräte in einem halben Jahr unterstützt werden und welche Funktionen neu hinzukommen, erfährt man, wenn man den aktuellen Entwickler-Kernel im Auge behält.

Linux 3.2

Mit der ersten Vorabversion von Linux 3.2 [1] bekam der Kernel auch gleich einen neuen Namen: Auf die „Divemaster Edition“ folgt „Saber-toothed Squirrel“ (in etwa: Säbelzahn-Eichhörnchen). Der Patch, der ein 3.1-Archiv auf 3.2-rc1 befördert, verirrte sich nicht nur in den falschen Pfad, er wurde nicht im Verzeichnis /testing sondern direkt unter v3.0 [2] veröffentlicht, und war diesmal verhältnismäßig groß. Das lag jedoch an Änderungen der Struktur des Kernel-Quellcodes, in der ganze Bäume verschoben wurden. Während die Versionsverwaltung Git damit problemlos zurecht kommt und das Verschieben innerhalb des Dateibaums abbilden kann, müssen die betroffenen Dateien im Patch einmal gelöscht und am neuen Ort wieder erstellt werden. Diese Aufräumarbeiten dauern schon länger an und sollen die Struktur übersichtlicher machen. Prominent waren das Zusammenziehen der TTY-Umgebung (die Umsetzung der Terminal-Schnittstelle) mit den Character Devices (zeichenorientierten Geräten) (siehe „Der Januar im Kernelrückblick“, freiesMagazin 02/2011 [3]), diesmal kamen der Bereich der Netzwerktreiber, die ARM-Architektur und der Zweig von User Mode Linux [4] dran. Die bedeutendste Neuerung in Torvalds Augen ging in der Masse dieser Umbauarbeiten unter: Änderungen an der virtuellen Speicherverwaltung [5], die die Steuerung von Schreibvorgängen auf Datenträger verbessern und dadurch für die meisten Endanwender spürbar sein sollen.

Linux 3.2-rc2 [6] konnte wieder im korrekten Pfad gefunden werden, nachdem Torvalds seine Skripte für die Veröffentlichung des Kernels korrigiert hatte. Es wurden insbesondere die Komponenten des freien Nouveau-Treibers für NVIDIA-Grafikchips mit Korrekturen bedacht und Erweiterungen an der Architektur-Unterstützung für Motorolas 6800-Prozessorfamilie vorgenommen. Dazu kommen Ergänzungen der Dokumentation für den DRM-Bereich (Direct Rendering Manager) und das Kernel-Testskript ktest.pl.

Den -rc3 [7] legte Torvalds dann pünktlich zu Thanksgiving auf. Fiel der -rc2 noch vergleichsweise klein aus, bietet der -rc3 ein eher gewohntes Bild. Die Änderungen verteilen sich einigermaßen gleichmäßig über den ganzen Kernel, der DRM-Bereich sticht mit verschiedenen Korrekturen an den Treibern für Intel- und AMD/ATI-Grafik ein klein wenig hervor. Der WLAN-Treiber iwlwifi sorgte in -rc2 noch für eine Kernel Panic [8], wenn der WLAN-Chip abgeschaltet und der Treiber entladen werden sollte. Eine Änderung der Reihenfolge, in der die einzelnen Komponenten des Systems deaktiviert werden, soll das Problem nun beheben.

Waren die Vorabversionen 2 und 3 mit einer eher steigenden Anzahl an Änderungen behaftet, so deutet Linux 3.2-rc4 [9] auf eine Beruhigung der Entwicklung hin. Entsprechend sind die Änderungen auch überschaubar. An der ARM-Architektur selbst wurde abermals gearbeitet, ebenso an Samsungs auf ARM basierendem System-on-Chip-Plattform Exynos bzw. deren Grafik-Treiber. Auch btrfs wurde mit Fehlerkorrekturen bedacht. Vielleicht legt Torvalds uns dieses Jahr wieder einen Weihnachtskernel unter den Christbaum, da jedoch noch einige Probleme offen sind, lässt sich das nicht mit Sicherheit sagen.

ASPM

Ein langes Leiden begann mit Kernel 2.6.38, als ein Problem mit dem Active State Power Management (ASPM) [10] des PCI-Express-Bus auftrat. Betroffene Notebook-Nutzer mussten fortan mit drastisch verkürzten Laufzeiten leben, da die PCIe-Umgebung sich nicht mehr in den Schlaf schicken ließ.

Ursache war eine Änderung, die eigentlich Probleme in dem Fall verhindern sollte, dass das BIOS die Verwendung von ASPM zu unterbinden sucht. Hierbei wird eine Einstellung ausgelesen, die jedoch in vielen Fällen falsch gesetzt ist und somit bewirkt, dass ASPM, obwohl eigentlich verfügbar, deaktiviert wird. Die Folge ist ein erhöhter Energiebedarf des PCIe-Busses, da er dauerhaft aktiviert bleibt.

Zwischenzeitlich wurde ein Patch [11] auf Basis des ursprünglichen Übeltäters vorgestellt, der jedoch ASPM nur dann wirklich deaktiviert, wenn die vollständige Kontrolle über PCIe beim Betriebssystem liegt und es damit die eigenen Mechanismen zum Energiemanagement nutzen kann anstelle des in PCIe integrierten ASPM. Das Ubuntu Kernel Team testet den Patch mittels eines angepassten Kernels für Ubuntu 11.10 und die Entwicklungsversion 12.04 [12].

Links

[1] https://lkml.org/lkml/2011/11/7/562

[2] https://www.kernel.org/pub/linux/kernel/v3.0/

[3] http://www.freiesmagazin.de/freiesMagazin-2011-02

[4] https://de.wikipedia.org/wiki/User_Mode_Linux

[5] https://de.wikipedia.org/wiki/Virtuelle_Speicherverwaltung

[6] https://lkml.org/lkml/2011/11/15/237

[7] https://lkml.org/lkml/2011/11/23/578

[8] http://de.wikipedia.org/wiki/Kernel_panic

[9] https://lkml.org/lkml/2011/12/1/517

[10] http://en.wikipedia.org/wiki/Active_State_Power_Management

[11] https://lkml.org/lkml/2011/11/10/467

[12] https://wiki.ubuntu.com/Kernel/PowerManagement

| Autoreninformation |

| Mathias Menzer (Webseite)

hält einen Blick auf die Entwicklung des Linux-Kernels und erfährt frühzeitig Details über interessante Funktionen.

|

| |

Diesen Artikel kommentieren

Zum Index

von Jochen Schnelle

Python ist heutzutage eine feste Größe unter den Programmiersprachen –

auch, wenn es um das Schreiben von Webanwendungen geht. Wer eine solche

programmiert, möchte früher oder später auch Daten vom Nutzer eingeben

lassen. Hier kommen dann HTML-Formulare ins Spiel. Im Rahmen dieses

Artikels werden fünf verschiedenen Frameworks für Python vorgestellt,

welche den Umgang mit diesen Formularen erleichtern sollen.

Warum ein Formular-Framework?

Zugegebenermaßen ist das Erstellen eines Formulars in HTML kein

Hexenwerk, sondern vergleichsweise sogar einfach. Ein Framework dient

aber nicht alleine zur Erstellung des Formulars aus Python heraus,

sondern übernimmt direkt auch noch die Typenkonvertierung und

Validierung der Eingaben, was für den Programmierer äußerst praktisch

ist.

Gibt man Daten in ein HTML-Formular ein, werden diese vom Browser an

den Server bzw. die Anwendung als Text übertragen, sodass in der

Anwendung erst einmal alles als String ankommt. Nun gibt es aber eine

Vielzahl von Fällen, bei der als Eingabe beispielsweise eine Zahl erwartet

wird, wie z. B. beim Alter in Jahren oder einer Hausnummer. Hier führen

die Frameworks direkt eine Typenprüfung und -konvertierung von String

nach Integer durch – oder melden einen Fehler, wenn der eingegebene

Wert keine ganze Zahl ist. Somit kann das unter Umständen recht

aufwendige Prüfen und Konvertieren „von Hand“ entfallen. Alle

Frameworks stellen solche Felder und Prüfungen auch für

Gleitkommazahlen, Datum usw. bereit.

Hat man alle Daten vom Nutzer erhalten und erfolgreich konvertiert,

stellen alle Frameworks als weiteren Schritt der Validierung eine

Überprüfung der Daten bereit. In deren Rahmen wird getestet, ob z. B.

alle Pflichtfelder ausgefüllt wurden. Somit kann auch dafür die

händische Prüfung entfallen.

Sollte die Konvertierung oder Validierung fehlschlagen, so erzeugen

alle Frameworks direkt eine Liste von Fehlern, zumeist unterteilt in

den Feldnamen und den zugehörigen Fehler. Diese kann dann angezeigt

werden, zusammen mit der Aufforderung an den Nutzer, das Formular

erneut und richtig auszufüllen.

Ein weiterer Vorteil ist, dass die meisten Frameworks automatisch

ausklappbare Auswahlfelder generieren können, sodass das lästige

Tippen von <option>…</option> entfällt.

Client-seitige vs. Server-seitige Validierung

Natürlich können in ein HTML-Formular eingegebene Daten auch

Client-seitig via Javascript geprüft werden, diverse

Javascript-Frameworks stellen hierfür die benötigten Funktionen bereit.

Nichtsdestotrotz sollte immer zusätzlich auch eine serverseitige

Validierung erfolgen, da der HTML-Header, welcher die gesendeten

Formulardaten enthält, auch nach der clientseitigen Validierung noch

manipuliert werden kann. Abgesehen davon ist auf dem Server die

Konvertierung der Daten so oder so erforderlich. Und dieser Vorgang ist

bei allen vorgestellten Frameworks mit der Validierung verbunden.

Aufbau des Artikels

Im Rahmen dieses Artikels werden fünf verschiedene Frameworks für

Python zum Umgang mit HTML-Formularen vorgestellt: Deform, WTForms,

FormAlchemy, Fungiform und Flatland. Dabei handelt es sich in der Tat

um eine Vorstellung, nicht etwa um einen Vergleichstest oder

Ähnliches.

Mit jedem Framework sollen zwei Formulare erstellt werden. Dabei

kommen verschiedene Feldtypen und Validatoren zum Einsatz. Das erste

Formular heißt UserData und enthält drei Felder: Name, Geburtstag

und Geschlecht. Der Name darf beliebig sein, außer „admin“ oder

„superuser“. Das Feld Geschlecht soll ein Auswahlfeld mit den

Auswahlmöglichkeiten „männlich“ und „weiblich“ sein, das Feld

Geburtstag soll optional sein. Im zweiten Formular namens LoginForm

soll ein einfaches Login-Formular erstellt werden. Auch hier gibt es

drei Felder: E-Mail-Adresse, Passwort und Wiederholung – alles

Pflichtfelder. Die eingegebene E-Mail Adresse soll einer rudimentären

Prüfung unterzogen werden, nämlich ob ein @-Zeichen darin vorkommt.

Ein weiterer Validator soll sicherstellen, dass die Eingaben für

Passwort und Wiederholung identisch sind.

Danach wird innerhalb einer Python-Shell ein wenig mit den Frameworks

und Formularen experimentiert. Dabei wird z. B. testweise ein

HTML-Formular aus der Vorlage generiert, Daten übergeben und eine

Validierung durchgeführt.

Am Ende des Artikels werden noch einige Framework-unabhängige Hinweise

gegeben, wie die Programme innerhalb einer Webanwendung eingebaut und

genutzt werden können.

Alle Beispiele sind unter Python 2.6 und Python 2.7 getestet, die

getestete Versionsnummer der Frameworks ist jeweils im zugehörigen

Abschnitt angegeben.

Gemeinsamkeiten

Es gibt in der Tat ein paar Gemeinsamkeit der Kandidaten. So arbeiten

alle fünf Frameworks intern mit Unicode-Daten – was unter Python auch

üblich ist. Dies bedeutet aber auch, dass die vom HTML-Formular

gesendeten Daten zuerst nach Unicode dekodiert werden müssen, da eine

Webseite immer kodierte Daten schickt (z. B. UTF-8, ISO-8815-1 usw.).

Einige der Frameworks haben bereits einen eingebauten Validator zur

Prüfung einer E-Mail-Adresse. Dieser ist aber in allen Fällen wirklich

minimalistisch, d. h. es wird nur geprüft, ob ein @-Zeichen vorkommt,

gegebenenfalls auch noch, ob ein Punkt zur Abgrenzung der

Top-Level-Domain vorhanden ist. Wer also ein HTML-Formular mit Eingabe der

E-Mail Adresse schreiben möchte und dann auch E-Mails an diese Adresse

versenden will sollte auch noch weitergehende Prüfungen

implementieren, wie z. B. das Senden einer Bestätigungsmail.

Alle Frameworks stellen HTML-Code nach der Version 4 dar. HTML 5,

welches ja auch bei Formularelementen einige Neuerungen bietet, kommt

nicht zum Einsatz. Eine Python-3-Version gibt es scheinbar für keines

der Frameworks, jedenfalls gibt es keinen offensichtlichen Hinweis

darauf. Und zu guter Letzt sei noch erwähnt, dass alle fünf Kandidaten

unter einer Open-Source-Lizenz stehen.

Deform

Das erste vorgestellt Framework ist Deform [1],

welches in

Rahmen des Pylons-Projekts entwickelt wird. Deform ist dabei aber

komplett unabhängig von Pylons und Pyramid und kann auch in

Kombination mit anderen Webframeworks genutzt werden.

Für diesen Artikel wird die aktuelle und stabile Deform-Version 0.9.3 verwendet.

Bei der Installation werden drei weitere Abhängigkeiten mit

installiert, nämlich Colander [2],

Peppercorn [3] und

Chameleon [4]. Während der Nutzer mit den

letzten beiden Modulen nicht in direkten Kontakt kommt, wird von

Colander direkt gebraucht gemacht, nämlich zum Anlegen des

Formularschemas.

Sowohl Deform als auch Colander sind vollständig und umfassend

dokumentiert.

Klassen für Formulare mit Deform

Die Definition der HTML-Formulare erfolgt, wie auch für die anderen

Frameworks, in Klassen.

Die beiden Klassen sehen hier so aus:

# -*- coding: utf-8 -*-

import colander

from deform.widget import SelectWidget, CheckedPasswordWidget

class UserData(colander.MappingSchema):

def none_off(value):

if value in ('admin','superuser'):

return False

else:

return True

name = colander.SchemaNode(colander.String(),

validator = colander.Function(none_off,

message = u'nicht erlaubter Benutzername'))

birthday = colander.SchemaNode(colander.Date(),

missing = '0000-00-00')

gender = colander.SchemaNode(colander.String(),

widget = SelectWidget(values=(

(u'männlich',u'männlich'),(u'weiblich',u'weiblich'))))

class LoginForm(colander.MappingSchema):

email = colander.SchemaNode(colander.String(),

validator = colander.Email(

msg = u'Dies ist keine gültige E-Mail Adresse'))

password = colander.SchemaNode(colander.String(),

widget = CheckedPasswordWidget())

Listing: deform_forms.py

Als Erstes erfolgen die notwendigen Importe. Dabei wird zuerst

Colander importiert, welches, wie oben bereits erwähnt, zur Definition

der Struktur dient. Des Weiteren werden noch zwei „Widgets“

importiert, welche später für die Darstellung von bestimmten

Formularfeldern verantwortlich sind.

Wie zu sehen ist, ist jedes Formularfeld ein SchemaNode, also ein

Knoten des Gesamtschemas. Für jeden Knoten ist wiederum ein Datentyp

festgelegt, hier in diesen Beispielen wird nur String und Data

verwendet. Bei den Feldern gender und password wird zusätzlich

noch ein Widget angewendet. Im ersten Fall dient dieses dazu, ein

Auswahlmenü zu generieren, im zweiten Fall zum Darstellen einer

Passworteingabe, inklusive Wiederholung. Gerade das letzte Widget

namens CheckPasswordWidget ist recht praktisch, da durch dessen

Einsatz nur ein Passwortfeld angelegt werden muss. In den anderen

Frameworks sind das Passwort und die Wiederholung eigene Felder.

Des Weiteren kommen hier auch Validatoren zum Einsatz. Diese sind Teil

der Klasse colander.SchemaNode und müssen nicht separat importiert

werden. Über msg = '...' können innerhalb der Validatoren eigene

Fehlermeldungen festgelegt werden. In der Klasse UserData kommt

weiterhin ein selbst geschriebener Validator zum Einsatz. Dies ist die

innerhalb der Klasse definierte Funktion none_of, welche prüft, ob

der in das Formularfeld eingegebene Benutzername nicht in der Liste

der nicht erlaubten Namen enthalten ist. Per Voreinstellung sind alle

Felder als Pflichtfelder gekennzeichnet, d. h. es wird eine Eingabe

erwartet. Soll ein Feld optional sein, so wie hier das Geburtsdatum,

dann ist dass Argument missing zu hinterlegen, wie auch hier im Feld

birthday. Damit wird ein Vorgabewert festgelegt, der die fehlende

Eingabe ersetzt.

Deform in der Konsole

Im Folgenden werden einige „Versuche“ mit Deform in einer Python-Shell

durchgeführt. Wie bereits erwähnt wurde bis jetzt nur die Struktur der

Formulare mit Hilfe von Colander festgelegt. Zum Überführen in eine

Klasse für ein Formular muss zuerst noch die Basisklasse von Deform

für alle Formulare importiert werden:

>>> from deform import Form

Dann werden die beiden Klassen aus Listing 1 importiert:

>>> from deform_forms import UserData, LoginForm

Jetzt kann eine Formularklasse abgeleitet werden. Dabei können direkt

die gewünschte action für das Formular sowie eine Senden-Schaltfläche

hinzugefügt werden:

>>> ud = Form(UserData(), action = '/foo', buttons = ('submit',))

Die Angabe von action und buttons ist dabei optional. Das

HTML-Formular kann nun gerendert werden:

>>> ud.render()

u'<form id="deform" action="/foo" method="POST" [...] <li title="" id="item-deformField1"> <!-- mapping_item --><label> <class="desc" title="" for="deformField1">Name<span class="req" id="req-deformField1">*</span></label> <input type="text" name="name" value="" id="deformField1"/> [...] </form>'

Die Ausgabe ist stark gekürzt, weil der HTML-Code sonst den Rahmen des

Artikels überschreiten würde. Wie zu sehen ist, generiert Deform direkt

das komplette HTML, also inklusive <form>-Tags etc. Auch wenn es im

obigen Beispiel nicht zu sehen ist, bindet Deform auch direkt

Javascript-Code mit ein. Die passenden Skripte werden bei der

Installation des Frameworks mit kopiert und liegen im

Installationsverzeichnis von Deform im Unterverzeichnis /scripts.

Ebenso bringt Deform direkt passende Stylesheets mit, diese liegen im

Unterverzeichnis /css. Der Einsatz der Skripte und der Stylesheets

in der eigenen Applikation ist aber optional, die gerenderten

Formulare können auch ohne Weiteres allein genutzt werden.

Als nächstes werden Daten an das Formular

übergeben und diese dann validiert. Die Daten erwartet Deform als

Tuple von 2er-Tuplen, was übrigens von den meisten Webframeworks

standardmäßig auch geliefert wird:

>>> mydata = (('name','Otto'),('gender',u'männlich'),('birthday','1977-1-1'))

>>> ud.validate(mydata)

{'gender': u'm\xe4nnlich', 'birthday': datetime.date(1977, 1, 1), 'name': u'Otto'}

Und noch eine nicht erfolgreiche Validierung:

>>> mydata = (('name','admin'),('gender',u'männlich'),

('birthday','1977-1-1'))

>>> ud.validate(mydata)

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

File "/usr/local/lib/python2.6/dist-packages/deform-0.9.3-py2.6.egg/deform/field.py", line 519, in validate

raise exception.ValidationFailure(self, cstruct, e)

deform.exception.ValidationFailure

Hier geht Deform einen etwas anderen Weg als die anderen Frameworks:

Bei erfolgreicher Validierung wird nicht True zurückgeliefert,

sondern die validierten Daten als Dictionary. Im Falle einer

fehlerhaften Validierung wird eine Exception geworfen. Möchte man die

Fehlermeldungen sehen, so muss man erneut die render()-Methode der

Formularklasse aufrufen. Der HTML-Code enthält dann alle Fehlermeldungen:

>>> ud.render()

[...]

class="error" id="error-deformField1">nicht erlaubter Benutzername</p>

[...]

Da Deform bei Nicht-Validierung immer einen Fehler wirft,

muss in einer Applikation natürlich immer ein try...except-Block

genutzt werden. Ein Beispiel dazu ist in der Dokumentation zu finden [5].

Weitere Funktionen

Neben den hier gezeigt Feldtypen kennt Deform natürlich auch noch eine

Reihe weiterer Felder, z. B. für Integerwerte. Außerdem bietet das

Framework unter Einsatz von Javascript auch die

Möglichkeit der

automatischen Vervollständigung von Eingaben in Felder [6].

Durch den Einsatz von Colander für die Definition des Schemas ist es

auch ohne weiteres möglich, komplexer und verschachtelte

Datenstrukturen darzustellen.

WTForms

Das nächste Framework ist WTForms [7],

welches in der Version 0.6.2 vorliegt. Das Framework ist als stabil

und für den produktiven Einsatz bereit gekennzeichnet.

WTForms beansprucht für sich selbst, ein „einfaches“ Framework zu

sein, mit dem man schnell und mit wenig Aufwand Formulare erstellen kann.

Weiterhin ist das Framework so

gestaltet, dass sich damit generierte Formularelemente ohne Probleme in Templates einfügen lassen, ohne dass darin

größere Änderungen von Nöten sind.

Die Dokumentation von WTForms [8]

ist vollständig. Der Umfang ist kompakt,

verständlich geschrieben und gut strukturiert, sodass diese schnell

gelesen ist.

WTForms hat bei der Installation keine Abhängigkeiten, d. h. es werden

nur die Dateien des Frameworks selbst installiert.

Formulare mit WTForms

Die beiden Formularen sehen mit WTForms so aus:

# -*- coding: utf-8 -*-

from wtforms import Form, TextField, SelectField, DateField, \

PasswordField, SubmitField, validators

class UserData(Form):

name = TextField(u'Name',

[validators.Required(),validators.NoneOf(

('admin','superuser'))])

birthday = DateField(u'Geburtsdatum',[validators.Optional()])

gender = SelectField(u'Geschlecht',

choices=[(u'männlich',u'männlich'),

(u'weiblich',u'weiblich')])

send = SubmitField(u'Senden')

class LoginForm(Form):

email = TextField(u'E-Mail Adresse',

[validators.Email()])

pass1 = PasswordField(u'Password',

[validators.Required(), validators.EqualTo('pass2',

message=u'Passwörter müssen übereinstimmen')])

pass2 = PasswordField(u'Password Wiederholung')

send = SubmitField(u'Senden')

Listing: wtforms_forms.py

Wie

zu sehen ist, erfolgen alle notwendigen Importe direkt aus der

obersten

Ebene des Moduls heraus. Importiert werden Form – welches

die Basisklasse für Formulare ist, diverse Feldelemente sowie die

enthaltenen Validatoren.

Die Instanzen der Formulare leiten sich von vordefinierten

Feldtypen ab, wobei die weiteren Angaben alle optional sind.

Nichtsdestotrotz ist es empfehlenswert, zumindest immer ein Label

anzugeben, wie im obigen Beispiel auch. Dieses ist später beim Anzeigen

des Formular nützlich. Das Label ist dabei das erste Argument. Als

zweites Argument kann eine Liste von anzuwendenden Validatoren

übergeben werden, dann können weitere optionale Elemente folgen. Im

Falle des Felds gender ist dies z. B. choices, welches die Optionen

für die Auswahlliste enthält. WTForms erwartet die Optionen als Liste

von Tupeln, wobei das erste Element des Tupels der Name der Option

ist, das zweite die Option, welche in der Liste angezeigt wird. Das

erste und zweite Element müssen also nicht gleich sein. Weiterhin ist die „Submit“-Schaltfläche in WTForms ein

eigenes Formularelement.

Im obigen Beispiel werden nur Validatoren verwendet, welche WTForms

bereits mitbringt. Da es von diesen eine recht umfangreiche Auswahl

gibt, ist eine Definition von eigenen Validatoren nicht notwendig –

aber grundsätzlich natürlich möglich. Im Feld name wird mit Hilfe

von NoneOf geprüft, ob die folgenden Begriffe nicht gleich der

Eingabe sind. birthday ist als optional gekennzeichnet, d. h. erfolgt

hier keine Eingabe, validiert das Formular trotzdem. Falsche Eingaben

führen natürlich trotzdem zu einem Fehler. Der Validator EqualTo im

Feld pass1 prüft, ob die Eingabe identisch mit der im Feld pass2

ist. Außerdem wird hier mit message=... eine eigene Fehlermeldung

hinterlegt, welche die standardmäßig hinterlegte (englischsprachige)

Fehlermeldung ersetzt.

WTForms in der Python-Shell

Nach dem obligatorischen Import der Klassen mit den Formularen

>>> from wtforms_forms import UserData, LoginForm

wird eine eigene Klasse ud von UserData abgeleitet:

>>> ud = UserData()

Das Rendern der Formularfelder ist dabei denkbar einfach. Dazu wird

einfach das darzustellende Feld der Klasse aufgerufen:

>>> ud.name()

u'<input id="name" name="name" type="text" value="" />'

>>> ud.send()

u'<input id="send" name="send" type="submit" value="Senden" />'

Im Gegensatz zum weiter oben gezeigten

Deform – und auch im Gegensatz

zu den noch folgenden FormAlchemy und Fungiform – rendert WTForms

nicht das ganze Formular, sondern nur die jeweiligen Felder. Die

<form>-Tags inklusive action=... müssen also manuell gesetzt werden.

Wie bei der Klassendefinition der Formulare bereits erwähnt, können die

Label separat gerendert werden:

>>> ud.name.label()

u'<label for="name">Name</label>'

Der Vorteil ist, dass später so mehr Flexibilität bei der Darstellung

in der Webapplikation besteht, dafür aber auch mehr Code-Zeilen nötig

sind.

Als Nächstes werden direkt Daten an das Formular übergeben und die

Validierung aufgerufen:

>>> ud = UserData(name='Otto',birthday='1977-1-1',gender=u'männlich')

>>> ud.validate()

True

Da alle Daten im Gültigkeitsbereich liegen, validiert das Formular

natürlich. Im folgenden Beispiel wird für name ein nicht gültiger

Wert übergeben, sodass das Formular nicht validiert:

>>> ud = UserData(name='admin',birthday='1977-1-1',gender=u'männlich')

>>> ud.validate()

False

Die Fehler können wie folgt aufgerufen werden:

>>> ud.errors

{'name': [u"Invalid value, can't be any of: admin, superuser."]}

Da keine eigene Fehlermeldung für diese Validierung in der Klasse

hinterlegt wurde, gibt WTForms die Standardfehlermeldung aus. Die

Fehler stehen übrigens in einer Liste, weil ein Feld durchaus auch

mehrere Fehler enthalten kann, je nachdem, wieviele und welche

Validatoren hinterlegt sind.

Weiteres zu WTForms

WTForms bietet neben den hier gezeigten Feldern auch alle anderen

gängigen Feldtypen. Das Anlegen eigener, neuer Feldtypen ist ebenfalls

möglich. Hinweise dazu findet man in der offiziellen Dokumentation.

Des Weiteren gibt es einige offizielle Erweiterungen

zu WTForms [9].

Diese erlauben unter

anderem die vereinfachte Nutzung von WTForms in Kombination mit

Django, SQLAlchemy und der Google-App-Engine.

FormAlchemy

FormAlchemy [10] trägt von allen

hier vorgestellten Programmen die höchste Versionsnummer, nämlich

1.4.1 und ist natürlich entsprechend als „stable“ gekennzeichnet. Wie

der Name vermuten lässt, gibt es eine Verbindung zu SQLAlchemy [11],

einem der populärsten Object-Relational-Mapper für SQL-Datenbanken

unter Python. FormAlchemy kann nämlich für

SQLAlchemy-Modelle bzw. gemappte Klassen direkt HTML-Formulare

erstellen. Dies ist sehr praktisch, wenn man seine Daten ohnehin

über diesen ORM abruft und speichert, zumal FormAlchemy

Formulareingaben auch direkt wieder in der Datenbank speichern kann.

Aber das Framework kann auch Formulare „konventionell“ erstellen, so

wie die anderen hier vorgestellten Programme auch. Dies wird im Rahmen

dieses Artikels behandelt. Der einzige Unterschied zur direkten

Anbindung an SQLAlchemy ist übrigens, dass man bei „manuellen“

Formularen die Definition händisch vornehmen muss, alle anderen

Schritte sind gleich.

Bei der Installation werden drei Abhängigkeiten mit

installiert, nämlich WebOb [12],

Webhelpers [13],

Tempita [14] und SQLAlchemy.

Klassen für das Formular

Bei der händischen Definition von Formularen werden auch in

FormAlchemy Klassen verwendet. Im Gegensatz zu den anderen Frameworks

sind diese hier aber normale New-Style-Pythonklassen, d. h. es wird

keine generische Basisklasse für Formulare zugrunde gelegt. Das

Framework kennt natürlich auch verschiedene Datentypen, im FormAlchemy

als „types“ bezeichnet. Und es gibt eine Reihe von eingebauten

Validatoren, wie z. B. required(). Das Anlegen eigener Validatoren ist auch möglich. Außerdem

kann man in FormAlchemy bei der Definition eines Felds in einem

Formular optional den „Renderer“ festlegen, also wie das Feld später

dargestellt wird. Natürlich sind hier alle Feldtypen mit sinnvollen

Voreinstellungen vorbelegt, trotzdem besteht hier noch bei Bedarf die

Flexibilität, auch Spezialfälle abbilden zu

können.

Die Definition der Klassen sieht in FormAlchemy

so aus:

# -*- coding: utf-8 -*-

from formalchemy import Field, types

from formalchemy.validators import email, length, ValidationError

class UserData(object):

def check_name(value,field):

if field.value in ['admin','superuser']:

raise ValidationError(u'Verbotener Benutzername')

name = Field(type=types.String).label(u'Name').required()\

.validate(check_name)

birthday = Field(type=types.Date).label(u'Geburtstag')

gender = Field(type=types.String).label(u'Geschlecht').dropdown(

options=[

(u'männlich', u'männlich'), (u'weiblich',u'weiblich')])

class LoginForm(object):

def pass2_validator(value, field):

if field.parent.pass1.value != value:

raise ValidationError(u'Keine Übereinstimmung.')

myemail = Field(type=types.String).required().validate(email)

pass1 = Field(type=types.String).password().required()

pass2 = Field(type=types.String).password().required()\

.validate(pass2_validator)

Listing: FormAlchemy_forms.py

Zu Beginn gibt es die obligatorischen Importe, dann folgt die

Definition der Klasse UserData. Wie zu sehen ist, ist jedes

Formularelement vom Typ Fields, die Festlegung von type=... ist

Pflicht, alle folgenden Punkte optional. label(...) definiert ein

Label, required() legt fest, ob ein Feld ein Pflichtfeld ist,

validate(...) legt die zusätzlichen Validatoren fest.

In der Klasse UserData wird die Funktion check_name

definiert, welche dann im Feld name als Validator für den Benutzernamen eingesetzt wird.

Die Klasse Field kennt übrigens auch ein Attribute name, welches

aber beim manuellen

Schreiben von Klassen nicht verwendet werden darf,

da sonst später ein Fehler beim Anlegen eines FieldSet geworfen wird. FormAlchemy legt den Namen selber fest, wobei dieser

identisch ist mit der aus Field angelegten Klasse, im Falle von

UserData also name, birthday und gender.

Interessent ist bei gender, dass Auswahlmenüs erst als normales

Feld, hier vom Typ String, definiert werden und erst dann festgelegt wird,

dass es eine Dropdown-Liste sein soll. Bei Checkboxen und Radiobuttons

geschieht dies auf gleiche Art und Weise. Im zweiten Formular

LoginForm wird über password() bestimmt, dass dieses Feld ein

Passwortfeld ist. Weiterhin wird in dieser Klasse zuerst eine eigene

Funktion pass2_validator definiert, welche später bei pass2 als

eigener Validator dient.

Tests in der Python-Konsole

Um FormAlchemy noch näher kennenzulernen wird eine Python-Konsole

aufgerufen, um ein bisschen mit den Formularen

zu experimentieren.

Dazu werden aus FormAlchemy_forms.py beide Klassen importiert.

Außerdem wird noch FieldSet aus FormAlchemy benötigt.

>>> from formalchemy_forms import UserData, LoginForm

>>> from formalchemy import FieldSet

Mit Hilfe des FieldSet wird nun die eigentliche Klasse erzeugt, mit der

das HTML-Formular später generiert wird und mit deren Hilfe auch

Formulardaten validiert werden können.

>>> ud = FieldSet(UserData)

Der einfache Aufruf von userdata zeigt die enthaltenen Felder:

>>> ud

<FieldSet with ['birthday', 'gender', 'name']>

Das Generieren des HTML-Formulars geschieht über den Aufruf von

render():

>>> ud.render()

u'<div><label class="field_req" for="UserData--name">Name</label><input id="UserData--name" name="UserData--name" type="text" /></div> [...]'

Die Länge der Ausgabe ist dadurch

bedingt, dass FormAlchemy Datumsfelder per Voreinstellung als

Auswahlmenüs darstellt, zumindest für Monat und Tag. Das Jahr ist ein

Textfeld mit einer Länge von vier. Das Feld ist aber trotzdem

optional, sofern es nicht in der Klasse als required()

gekennzeichnet wird.

Außerdem ist ein kurzer Schnipsel Javascript enthalten, welcher den

Fokus direkt auf das erste

Eingabefeld setzt. FormAlchemy verwendet

vergleichsweise lange Namen für die einzelnen Felder, welche sich aus

dem Formularnamen, zwei Minuszeichen und dem Feldnamen zusammensetzen,

also z. B. UserData--name.

Die öffnenden und schließenden <form>-Tags werden nicht automatisch

generiert, ebenso erzeugt FormAlchemy nicht die „Senden“-Schaltflächen.

Dies muss also später in der Applikation

händisch erfolgen.

Es ist auch möglich, nur einzelne Felder aus dem Formular rendern zu

lassen:

>>> ud = FieldSet(UserData)

>>> ud.configure(include=[ud.name])

>>> ud

<FieldSet (configured) with ['name']>

>>> ud.render()

u'<div><label class="field_req" for="UserData--name">Name</label>[...]

Die Liste hinter include enthält die Feldnamen, die dargestellt

werden sollen. Es ist auch möglich, ein Liste von Feldnamen

auszuschließen. Dafür wird include einfach durch exclude ersetzt.

Um ein Formular zu validieren, müssen zuerst Daten an das

Formular übergeben werden. Dies geschieht direkt beim Anlegen des

FieldSet:

>>> logindata = {'LoginForm--myemail': 'foo@bar.de',

'LoginForm--pass2': 'spamegg',

'LoginForm--pass1': 'spamegg'}

>>> lf = FieldSet(LoginForm, data=logindata)

>>> lf.data

SimpleMultiDict([('LoginForm--myemail', u'foo@bar.de'), ('LoginForm--pass2', u'spamegg'), ('LoginForm--pass1', u'spamegg')])

>>> lf.data['LoginForm--pass1']

u'spamegg'

>>> lf.validate()

True

Als Nächstes werden Daten übergeben, welche nicht validieren:

>>> baddata = {'LoginForm--myemail': 'foo_bar.de',

'LoginForm--pass2': 'spam',

'LoginForm--pass1': 'spamegg'}

>>> badform = FieldSet(LoginForm, data=baddata)

>>> badform.validate()

False

>>> badform.errors

{AttributeField(myemail): ['Missing @ sign'], AttributeField(pass2): ['Passw\xc3\xb6rter stimmen nicht \xc3\xbcberein.']}

>>> badform.render()

u'\n\n<div>\n <label class="field_req" for="LoginForm--myemail"> [...] <span class="field_error">Missing @ sign</span>\n</div>'

Auch diese Ausgabe ist gekürzt. Wie nicht anders zu erwarten, gibt der

Aufruf von validate() False zurück. Die Fehler sind in errors

hinterlegt. Wird das Formular gerendert, so werden die Fehler auch

direkt im Quelltext angezeigt.

Weitere Funktionen

Wie in der Einleitung bereits erwähnt, ist der Ursprung von FormAlchemy

das Generieren von Formularen aus gemappten Klassen aus SQLAlchemy.

Außerdem bietet das Framework auch Klassen und Funktionen, um

komplexere Formulare direkt in Form einer Tabelle darstellen zu lassen.

Des Weiteren gibt es unter anderem eine Anbindung von FormAlchemy an

CouchDB, Pylons sowie Zope, AJAX-basierte Formulare, die auf jQuery

zurückgreifen [15] sowie eine

Anbindung an Pyramid [16]. Wer sich näher mit

FormAlchemy beschäftigen möchte, der sollte einen Blick in die sehr

ausführliche und gut strukturierte Dokumentation [17] werfen.

Fungiform

Fungiform [18]

entstammt dem Pocoo-Umfeld [19] und war

ursprünglich Teil der in Python geschriebenen Blogsoftware „Zine“ [20],

wurde aber 2010 als eigenständiges Framework ausgelagert.

Fungiform trägt zwar „nur“ die Versionsnummer 0.1, ist in sich aber

ziemlich komplett, weiterhin gibt es scheinbar keine größeren Bugs

mehr. Jedenfalls traten bei den Tests mit Fungiform im Rahmen dieses

Artikels keine Probleme auf. Apropos Probleme: Es gibt zwei andere

„Probleme“ mit Fungiform. Das eine ist, dass es scheinbar keine

aktiven Entwickler gibt. Nach der Auslagerung von Fungiform im Sommer

2010 gab es zwar diverse kleinere Korrekturen, aber keine eigentliche

Weiterentwicklung. Der letzte Commit zum Quellcode stammt von Ende

2010. Das zweite, nicht ganz so große Problem ist, dass es keine

separate Dokumentation im HTML-Format oder ähnlichem gibt. Dies lässt

sich aber verschmerzen, da der Quellcode sehr gut und sehr ausführlich

dokumentiert ist. Wer sich mit Fungiform beschäftigen möchte, der

sollte Gebrauch von der in Python eingebauten help()-Funktion machen

oder die Doc-Strings direkt im Quelltext lesen. Die wichtigste Datei

ist dabei forms.py [21],

welche so gut wie alle Klassen und Funktionen enthält, die man später

auch für das eigene Programm benötigt.

Definition der Klassen

Wie bei den anderen bisher vorgestellten Frameworks wird auch hier die Struktur

für das HTML-Formular in einer Python-Klasse hinterlegt. Es gibt die

üblichen Feldtypen für Text, Zahlen, Auswahllisten usw. Weiterhin gibt

es einige „speziellere“ Formularelemente, wie z. B. zur Eingabe von

Komma-separierten oder Zeilenumbruch-separierten Daten. Außerdem kann

man auch in Fungiform Validatoren hinterlegen. Was sich bei Fungiform etwas

unterscheidet ist, dass einige „Basis-Validatoren“ bereits in den

Feldklassen hinterlegt sind. So kann man für einige Klassen wie z. B.

TextField die Attribute required, min_length oder max_length

direkt definieren, ohne dafür einen separaten Validator anlegen zu

müssen. Davon wird auch im folgenden Beispiel Gebrauch gemacht. Im

Gegenzug kennt Fungiform allerdings keine anderen vordefinierten Validatoren

– wie z. B. WTForms und Deform – welche unabhängig von einer

Klasse sind. Dafür kann man aber sehr einfach eigene Validatoren

schreiben.

# -*- coding: utf-8 -*-

from fungiform.forms import FormBase, TextField, DateField, \

ChoiceField, PasswordField, ValidationError

class UserData(FormBase):

def is_valid_name(self,value):

if value in ['admin','superuser']:

message = u'unerlaubter Benutzername'

raise ValidationError(message)

name = TextField(label=u'Name', required=True,

validators=[is_valid_name])

birthday = DateField(label=u'Geburtsdatum')

gender = ChoiceField(label=u'Geschlecht',

choices=[u'männlich',u'weiblich'])

class LoginForm(FormBase):

def is_valid_email(self,value):

if '@' not in value:

message = u'ungültige E-Mail Adresse'

raise ValidationError()

email = TextField(label=u'Email', required=True,

min_length=6, max_length=120)

pass1 = PasswordField(label='Passwort', required=True)

pass2 = PasswordField(label='Wiederholung', required=True)

def context_validate(self, data):

if data['pass1'] != data['pass2']:

message = u'Passwörter stimmen nicht überein'

raise ValidationError(message)

Listing: fungiform_form.py

Wie man sieht, kommen alle Importe aus fungiform.forms. Importiert

wird die Basisklasse für alle Formulare FormBase sowie die

benötigten Klassen für Formularfelder und der ValidationError,

welcher für die selbstgeschriebenen Validatoren benötigt wird.

Die beiden Klassen UserData und LoginForm besitzen jeweils einen

selbstdefinierten Validator. Diesem muss immer value übergeben

werden, was der zu prüfende Wert ist. Der anschließende Code kann

beliebiger Python-Code sein. Wenn die Validierung nicht erfolgreich

war, wird der ValidationError geworfen, wobei diesem eine

benutzdefinierte Fehlermeldung mitgegeben werden kann.

Der sonstige Code der Klassen sollte weitestgehend selbsterklärend

sein. Ist ein Feld ein Pflichfeld (wie z. B. name), so setzt man das

Attribute required=True. Übergibt man später Fungiform für die

Validierung des gesamten Formulars keinen Wert für dieses Feld, so wird

ein entsprechender Fehler geworfen.

In der Klasse LoginForm wird ein zusätzlicher Validator namens

context_validate benutzt, welcher die beiden Passworteingaben

vergleicht. Besitzt eine Klasse diesen, so wird er auf die gesamte

Klasse (das gesamte Formular) angewendet und nicht, wie die anderen

Validatoren, nur auf einzelne Instanzen einer Klasse. Im Gegensatz zu

einem „Einzelvalidator“ muss man context_validate immmer data

übergeben, welches alle Formulardaten enthält.

Formulare benutzen

Als Erstes soll wieder der HTML-Quelltext für das Formular generiert

werden. Dies geschieht bei Fungiform in zwei Schritten: Zuerst ruft man

die Funktion as_widget() auf, dann wird erst das eigentliche HTML

erzeugt. Als Parameter wird dem Formular dabei die gewünschte Ziel-URL als action mitgegeben:

>>> from fungiform_form import UserData, LoginForm

>>> ud = UserData(action='/foo')

>>> ud_widget = ud.as_widget()

>>> ud_widget()

u'<form action="/foo" method="post"><dl class="mapping"><dt><label for="f_name">Name</label></dt><dd><input type="text" id="f_name" value="" name="name"></dd> [...] <div class="actions"><input type="submit" value="Submit"></div></form>'

Um den Umfang des Artikels nicht zu sprengen, ist auch diese Ausgabe

gekürzt.

Ein direktes Rendern ist auch möglich:

>>> ud.as_widget().render()

u'<form action="/foo" method="post"> [...]'

Wie zu sehen ist, fügt Fungiform auch die <form>...</form> Tags

automatisch hinzu, ebenso wird die „Submit“-Schaltfläche automatisch

generiert. Wie auch bei den anderen Frameworks wird in den Tags eine

id angelegt. Hier werden Default-Werte seitens Fungiform verwendet,

diese können vor der Formulargenerierung aber auch überschreiben

werden.

Die voreingestellte Methode zum Senden des Formulars ist post, dies

kann aber recht einfach geändert werden:

>>> ud.default_method = 'get'

>>> ud_widget = myform.as_widget()

>>> ud_widget()

u'<form action="/foo" method="get">...'

Die Label für die einzelnen Felder sind wie folgt abrufbar:

>>> ud.name.label

u'Name'

Wie die anderen Frameworks kann Fungiform die für ein Formular

übermittelten Daten automatisch validieren. Dies kann ebenfalls in der

Pythonkonsole getestet werden:

>>> mydata = {'name':'Otto','gender':u'männlich','birthday':'1977-7-7'}

>>> ud.validate(mydata)

True

Da alle Werte gültig sind, validiert das Formular ohne Fehler. Wie

zu sehen ist, wurde auch hier das Datum als String übergeben. Fungiform

wandelt diesen automatisch bei der Validierung in ein Datetime-Objekt

um. Dies ist zu sehen, wenn der übermittelte Wert aufgerufen wird:

>>> ud['birthday']

datetime.date(1977, 7, 7)

Alle Daten können wie folgt abgerufen werden:

>>> ud.data

{'gender':u'm\xe4nnlich','birthday':datetime.date(1977,7,7),'name':u'Otto'}

Als Nächstes werden an das Formular Daten übermittelt, welche nicht

gültig sind:

>>> mydata = {'name':'admin','gender':u'mann','birthday':''}

>>> ud.validate(mydata)

False

>>> ud.errors

{'name': [u'unerlaubter Benutzername'],

'gender': [u'Please enter a valid choice.']}

Wie erwartet validiert das Formular nicht. Die Fehlermeldungen werden in

errors gespeichert. Ruf man diese auf, sind die Fehlermeldungen

als Dictionary zu sehen. Sofern keine eigene Fehlermeldung vorgegeben

wurde – wie im Falle des Felds gender – wird die Standardfehlermeldung für diesen Feldtyp verwendet.

Der Status der letzten Validierung kann auch aufgerufen werden, ohne das

ganze Formular erneut zu validieren:

>>> ud.is_valid

False

Weitere Funktionen

Fungiform bietet natürlich noch weitere Möglichkeiten als die hier

gezeigten. So ist es z. B. auch möglich, eigene Feldtypen zu

definieren, Feldern „Widgets“ mitzugeben, um deren Verhalten zu ändern

usw. Dies ist auch in der eingebauten Dokumentation (kurz)

erklärt.

Eingangs wurde bereits erwähnt, dass auch Fungiform alle gängigen

Feldtypen generieren kann sowie ein paar „Extrafelder“ an Bord hat.

Des Weiteren unterstützt Fungiform den Einsatz

von Recaptchas [22]

und bietet mit Bordmitteln

Schutz vor Cross-Site-Request-Forgery [23].

Aufgrund der fehlenden Dokumentation müssen auch hier der Quelltext beziehungsweise die

Kommentare darin gelesen werden, um herauszufinden, wie diese

Funktionen zu nutzen sind.

Flatland

Flatland trägt ebenso wie Fungiform eine recht niedrige

Versionsnummer, nämlich 0.0.1, und wird auf PyPi [24] mit dem Status „beta“ deklariert. Laut

Homepage des Projekts [25] ist

das Framework komplett, frei von größeren Bugs, einsatzfähig und auch

tatsächlich im Einsatz. Bei den Tests mit Flatland für diesen Artikel

traten in der Tat keine Probleme auf – aber es fehlt noch

Dokumentation [26]. Dies ist

aktuell in der Tat das größte Manko von Flatland. Es gibt zwar eine

schon recht umfangreiche Dokumentation [27],

diese beschreibt aber fast ausschließlich das Anlegen von eigenen Klassen und den

Einsatz der

verschiedenen existierenden Felder. Eine Erklärung, wie man

aus einer Formularklasse HTML erzeugt, fehlt z. B. noch vollständig.

Glücklicherweise wurde auf der Europython 2010 ein Vortrag zu Flatland

gehalten, welcher die Nutzung komplett, wenn auch relativ kurz,

erläutert [28]. Wer sich näher mit Flatland

beschäftigen möchte, der sollte sich die Folien unbedingt ansehen.

Ähnlich wie das im Rahmen von Deform angesprochene Colander, kann

Flatland auch komplexere Datenstrukturen darstellen, da sich mehrere

Felder beliebig in Dictionaries und Listen zusammenfassen lassen.

Diese dürfen auch wiederum Dictonaries und Listen enthalten. Darauf

wird im Rahmen dieses Artikels aber nicht eingegangen.

Anlegen der Formulare

Die Klassen für die Formulare sehen mit Flatland so aus:

# -*- coding: utf-8 -*-

from flatland import Form, String, Date

from flatland.validation import Present, ValueIn, IsEmail, \

ValuesEqual, IsEmail

GENDER_DATA = [u'männlich',u'weiblich']

def not_allowed_name(element, state):

if element.value in ['admin','superuser']:

element.errors.append(u'Verbotener Name')

return False

class UserData(Form):

name = String.using(label = u'Name',

validators=[Present(missing=u'Kein Name eingegeben'),

not_allowed_name])

birthday = Date.using(label = u'Geburtsdatum',optional = True)

gender = String.using(label = u'Geschlecht',

validators=[Present(missing=u'Geschlechtsangabe fehlt'),

ValueIn(GENDER_DATA,fail =

u'"

class LoginForm(Form):

email = String.using(label='E-Mail',

validators=[

Present(missing=u'Kein E-Mail Adresse eingegeben'),

IsEmail(invalid=u'Keine gültige E-Mail Adresse')])

pass1 = String.using(label = u'Passwort',

validators=[Present(missing = 'Kein Passwort eingegeben')])

pass2 = String.using(label = u'Passwort Wiederholung',

validators=[Present(missing = 'Passwortwiederholung fehlt')])

validators = [

ValuesEqual(pass1,pass2)]

Listing: flatland_forms.py

Als Erstes werden wieder die notwendigen Importe durchgeführt, einmal

für die verwendeten Felder und einmal für die eingesetzten

Validatoren. Ansonsten wird für jedes Feld zuerst der Datentyp

festgelegt und danach das Label sowie die anzuwendenden Validatoren.

Weiterhin wird in der Klasse UserData ein eigener Validator namens

not_allowed_name definiert. Dieser wird später im Feld name

eingesetzt und prüft, ob der eingegebene Name innerhalb der nicht

erlaubten Liste von Namen liegt.

Bei der Klasse LoginForm wird ein Validator außerhalb der

Felddefinition eingesetzt. Dieser wird also auf das gesamte Formular

angewendet. Dies ist immer dann praktisch, wenn – so wie hier –

Eingaben aus verschiedenen Feldern miteinander verglichen werden

sollen. Etwas umständlich ist die Tatsache, dass Flatland zwar selbst

definierbare Fehlermeldungen bei nicht erfolgreicher Validierung

erlaubt, die Definition an sich aber nicht einheitlich ist. Wie auch

im Listing 5 oben zu sehen ist, wird die eigene Fehlermeldung im Falle des

Validators Present über missing = '...' festgelegt, im Falle des

Validators IsEmail aber über invalid = '...'. Einheitlicher

ist eher der Weg, den die anderen Frameworks

wählen,.

Im Gegensatz zu allen anderen hier vorgestellten Formular-Frameworks

kennt Flatland scheinbar keinen eigenen Feldtyp für ein Auswahlfeld.

„Scheinbar“ deshalb, weil im Rahmen der Recherche dieses Artikels

dieser Feldtyp zwar nicht aufzufinden war, es aber nicht

auszuschließen ist, dass das Auswahlfeld schlichtweg noch nicht

dokumentiert ist und somit nicht „gefunden“ wurde.

Tests mit Flatland in der Python-Shell

Im Folgenden werden die mit Flatland definierten Klassen für die

Formulare ein wenig in der Python-Shell erkundet. Zuerst werden die

beiden Formularklassen importiert,

>>> from flatland_forms import LoginForm, UserData

und eine eigene Klasse daraus instanziiert:

>>> ud = UserData()

Der Aufruf von ud gibt die Feldnamen und die aktuellen Werte zurück:

>>> ud

{u'birthday': <Date u'birthday';value=None>, u'name': <String u'name'; value=None>, u'sex': <String u'sex'; value=None>}

Da noch keine Werte übergeben wurden, ist value natürlich überall

None. Einzelne Felder sind wie bei Dictionaries aufrufbar:

>>> ud['name']

<String u'name'; value=None>

Die Label für Felder können wie folgt aufgerufen werden:

>>> ud['name'].label

u'Name'

Als Nächstes werden Daten an das Formular übergeben und validiert:

>>> from datetime import date

>>> mydata = {'name':'Otto',

'gender':u'männlich',

'birthday':date(1977,1,1)}

>>> ud.set(mydata)

True

>>> ud.validate()

True

>>> ud

{u'gender': <String u'gender'; value=u'm\xe4nnlich'>, u'birthday': <Date u'birthday'; value=datetime.date(1977, 1, 1)>, u'name': <String u'name'; value=u'Otto'>}

Flatland erwartet, wie zu sehen ist, für das Geburtsdatum explizit ein

Python-Date-Objekt. Ein String in der Form 1977-1-1, wie ihn die

anderen Frameworks als gültiges Datum akzeptieren, führt in Flatland

zu einem Fehler.

Als Nächstes wird das Formular gegen einen ungültigen Datensatz

validiert:

>>> mydata = {'name':'admin',

'gender':u'männlich',

'birthday':date(1977,1,1)}

>>> ud.set(mydata)

True

>>> ud.validate()

False

Wie nicht anders zu erwarten, schlägt die Validierung fehl. Leider

speichert Flatland keine Fehlerliste, welche für das ganze Formular

gilt. Vielmehr werden die Fehler in den jeweiligen zugehörigen Feldern

hinterlegt. Von daher muss man über diese iterieren, um die Fehler zu

sehen:

>>> for k in ud.iterkeys():

... print k, ud[k].valid

... print k, ud[k].errors

...

gender True

gender []

birthday True

birthday []

name False

name [u'Verbotener Name']

Flatland ist das einzige der hier vorgestellten Frameworks, das für

das Rendern der Formulare nach HTML einen eigenen Import benötigt,

nämlich den Generator:

>>> from flatland.out.markup import Generator

Dies ist übrigens zum Zeitpunkt des Schreibens dieses Artikels

vollständig undokumentiert, d. h. in der offiziellen Dokumentation

an keiner Stelle erwähnt.

Danach können die Formularfelder generiert werden:

>>> gen = Generator()

>>> gen.input(ud['name'], type='text')

<input type="text" name="name" value="" />

Ähnlich wie WTForms rendert Flatland die Felder einzeln. Das

komplette Rendern eines ganzen Formulars wird nicht unterstützt. Wie

zu sehen ist, wird über gen.input() ein <input>-Feld generiert,

type='text' legt den Typ als Textfeld fest.

Da Flatland scheinbar keine Auswahlfelder unterstützt,

müssen diese von Hand „gebaut“ werden:

>>> from flatland_forms import GENDER_DATA

>>> gen.select.open()

u'<select>'

>>> for i in GENDER_DATA:

... gen.option.open(),\

... i,gen.option.close()

...

u'<option> männlich </option>'

u'<option> weiblich </option>'

>>> gen.select.close()

u'</select>'

Der Generator aus Flatland ist also recht flexibel und kann alle für

Formulare benötigten HTML-Tags generieren. Nichtsdestotrotz ist

diese Vorgehensweise vergleichsweise aufwändig.

Sonstiges

Neben diversen weiteren Feldtypen sowie der Möglichkeit der

Verschachtelung von Feldern kennt Flatland auch noch „Signals“ [29].

Diese können in den Programmcode eingebaut werden und senden während

der Verarbeitung von Formularen zu oder nach einem bestimmten Ergebnis,

wie einer erfolgreichen Validierung, ein Signal an eine Liste

vordefinierter Empfänger. Des Weiteren gibt es eine Anbindung an die

beiden Template-Engines „Genshi“ und „Jinja2“ [30].

Weitere Alternativen

Die hier vorgestellten Programme stellen natürlich nur einen

Ausschnitt der existierenden Frameworks dar. Ein weiteres ist z. B.

FormEncode [31]. Noch mehr

Alternativen sind auf PyPi zu finden, wenn z. B. als Suchbegriff „html

form“ eingegeben wird.

Wird das für Webapplikationen auch sehr populäre Django [32]

genutzt, so steht hier ein eigenes Modul für HTML-Formulare bereit [33],

welches natürlich komplett in Django integriert ist.

HTML-Framework in Webapplikationen

Im Rahmen dieses Artikels wurden die verschiedenen Frameworks

ausschließlich in der Python-Shell erkundet. Die Nutzung innerhalb

einer realen Webapplikation ist aber auch nicht weiter schwierig,

zumal das prinzipielle Vorgehen grundsätzlich für alle vorgestellte Frameworks gleich ist.

Es gibt grundsätzlich drei verschiedene Zustände, die im

Programmablauf berücksichtigt werden müssen:

- es wurde noch kein Formular generiert

- es wurde ein ausgefülltes Formular von der Webseite gesendet, dieses validiert aber nicht, d. h. es enthält Fehler

- es wurde ein ausgefülltes Formular von der Webseite gesendet und dieses validiert

Weiterhin gilt es zu bedenken, dass alle Frameworks, wie weiter oben

bereits erwähnt, Unicode-Daten erwarten, die Webseite aber codierte

Daten liefert.

Im Folgenden wird eine minimale Webapplikation mit nur einem Formular

mit Hilfe von WTForms und Bottle (siehe Artikel in freiesMagazin 2/2011 [34]) gezeigt. Der Code ist nicht weiter spezifisch für Bottle und

sollte sich sehr einfach auch auf andere Webframeworks übertragen

lassen. Der Austausch von WTForms gegen ein anderes Formular-Framework

sollte sich auch einfach bewerkstelligen lassen. Der Code besteht

dabei aus zwei Teilen: Der Applikation an sich und dem zugehörigen

Template.

my_form_app.py

template.tpl

In my_form_app.py wird zuerst die notwendige Dekodierung von UTF-8 nach

Unicode für alle eingegebenen Werte durchgeführt. Dabei ist zu

beachten, dass es sich um eine „minimale“ Konvertierung im Rahmen

dieses Beispiels handelt. Das im Template generierte HTML stellt nicht

sicher, dass die Eingabe wirklich immer UTF-8 ist und fängt auch nicht

das mögliche Fehlverhalten älterer Browser (wie z. B. Microsofts Internet

Explorer 6)

ab.